النسب المتدرج هو نهج خوارزمي تكراري يستخدم في التعلم الآلي لتقليل دالة الهدف أو التكلفة. يتم استخدامه لتحسين معلمات النموذج، كما هو الحال في Gradient Descent Regression، لتحقيق الحد الأقصى أو الحد الأدنى من النقاط فيما يتعلق بمجموعة المعلمات. بمعنى آخر، الهدف هو العثور على المعلمات التي تقلل دالة التكلفة.

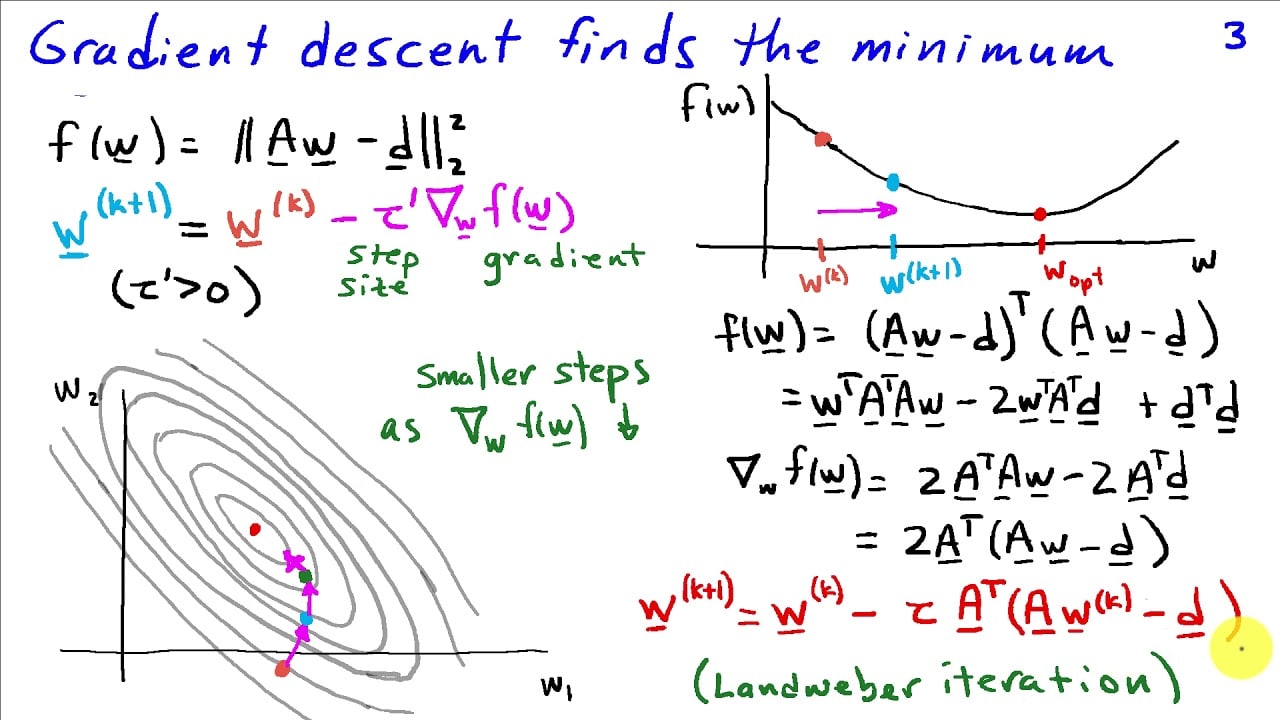

يعمل Gradient Descent عن طريق حساب تدرج دالة عند كل نقطة، ثم ضبط المعلمات وفقًا لذلك. التدرج هو مشتق دالة التكلفة فيما يتعلق بالمعلمة. إذا كان للمشتق قيمة سالبة، فإن المعلمة المثالية تتناقص. ويحدث العكس عندما يكون للمشتق قيمة موجبة. نظرًا لأن الخوارزمية تتبع التدرج التنازلي، فإنها تصل في النهاية إلى نقطة يكون فيها التدرج صفرًا. عند هذه النقطة، تكون المعلمات قد وصلت إلى نقطة الحد الأدنى المحلية.

بشكل عام، يعد Gradient Descent أسلوبًا مناسبًا تمامًا لتحسين الوظائف غير الخطية. إنه يعمل ضمن مجموعات البيانات الصغيرة بالإضافة إلى المجموعات الكبيرة المعقدة. كما أنه سهل التنفيذ لأنه يتبع نهجًا رياضيًا مباشرًا.

جزء مهم من خوارزمية Gradient Descent هو معدل التعلم. تحدد هذه المعلمة مدى سرعة قيام الخوارزمية بضبط المعلمات. يمكن أن يؤدي معدل التعلم الأعلى إلى تباعد الخوارزمية أو تذبذبها بدلاً من التقارب إلى نقطة الحد الأدنى المحلية. لذلك، يعد تحديد معدل التعلم المناسب جزءًا مهمًا من عملية تحسين Gradient Descent.

يتم استخدام Gradient Descent على نطاق واسع في تطبيقات التعلم الآلي مثل الشبكات العصبية أو أجهزة المتجهات الداعمة. كما يتم استخدامه في مجالات أخرى مثل محركات البحث أو معالجة اللغات الطبيعية.