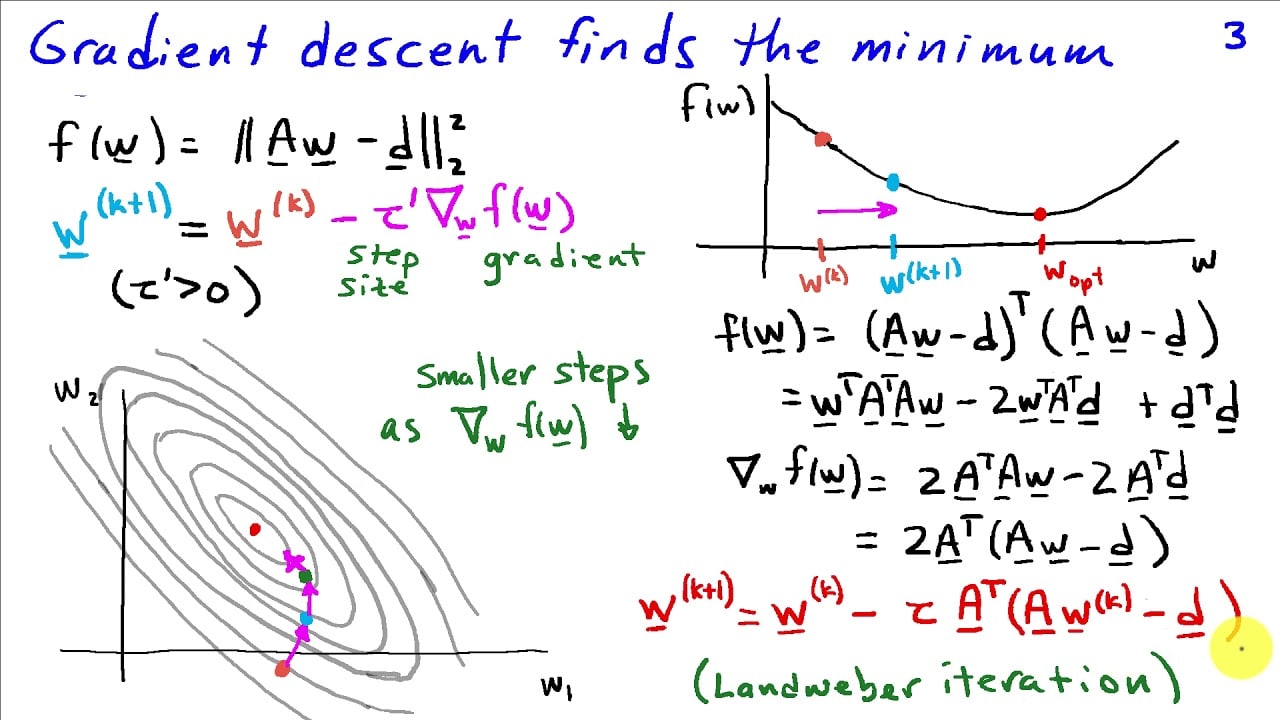

勾配降下法は、目的関数またはコスト関数を最小化するために機械学習で使用される反復アルゴリズムのアプローチです。これは、勾配降下回帰などでモデルのパラメーターを最適化し、パラメーターのセットに関して最大点または最小点を達成するために使用されます。言い換えれば、目標はコスト関数を最小化するパラメータを見つけることです。

勾配降下法は、各点で関数の勾配を計算し、それに応じてパラメーターを調整することで機能します。勾配は、パラメーターに関するコスト関数の導関数です。導関数が負の値を持つ場合、最適パラメータは減少しています。導関数が正の値を持つ場合は、その逆が当てはまります。アルゴリズムは下降勾配に従うため、最終的に勾配が 0 になる点に到達します。その時点で、パラメータは極小点に達していると考えられます。

一般に、勾配降下法は、非線形関数を最適化するのに適したアプローチです。これは、大規模で複雑なデータセットだけでなく、小規模なデータセット内でも機能します。また、単純な数学的アプローチに従っているため、実装も簡単です。

勾配降下法アルゴリズムの重要な部分は学習率です。このパラメータは、アルゴリズムがパラメータを調整する速度を決定します。学習率が高いと、アルゴリズムが極小点に収束せずに発散または振動する可能性があります。したがって、適切な学習率を選択することは、勾配降下法最適化プロセスの重要な部分です。

勾配降下法は、ニューラル ネットワークやサポート ベクター マシンなどの機械学習アプリケーションで広く使用されています。検索エンジンや自然言語処理などの他の分野でも使用されます。