梯度下降是机器学习中用于最小化目标或成本函数的一种迭代算法方法。它被用来优化一个模型的参数,例如在梯度下降回归中,以达到与参数集有关的最大或最小点。换句话说,目标是找到使成本函数最小化的参数。

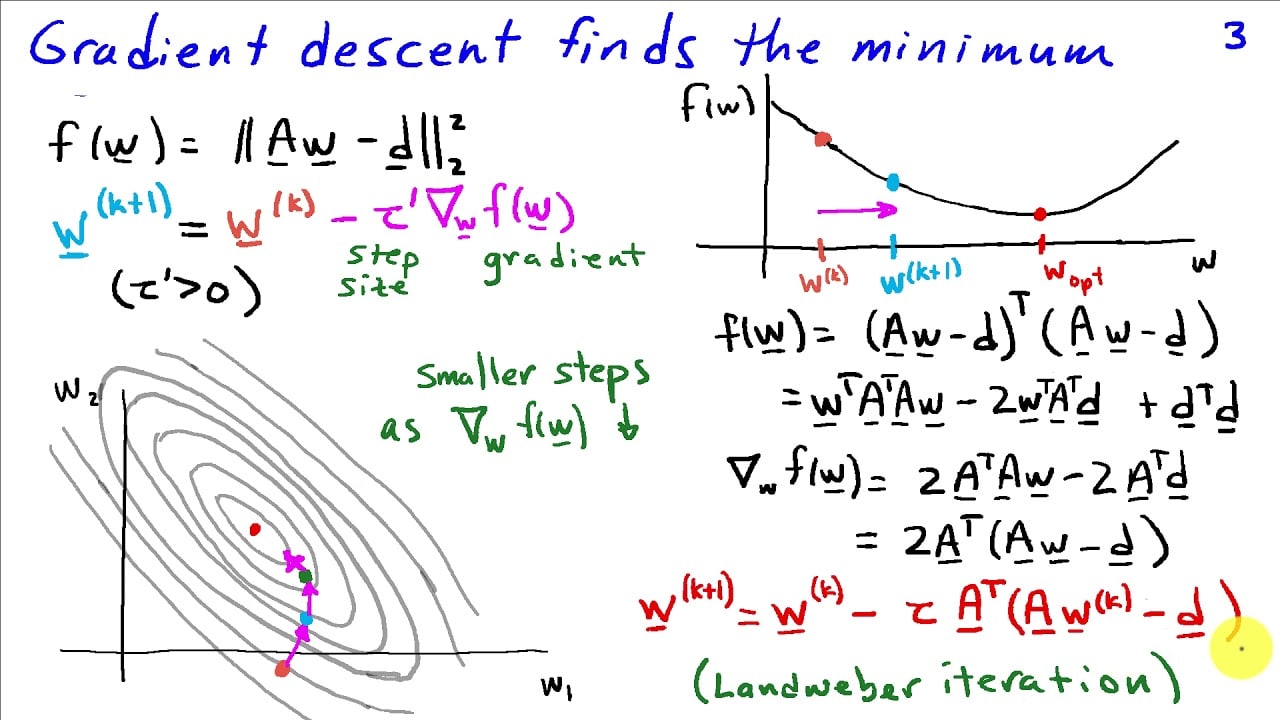

梯度下降法的工作原理是计算一个函数在每个点的梯度,然后相应地调整参数。梯度是成本函数相对于参数的导数。如果导数为负值,则最优参数是递减的。当导数为正值时则相反。当算法沿着下降的梯度前进时,它最终会到达一个梯度为零的点。在这一点上,参数将达到其局部最小点。

一般来说,梯度下降是一种非常适合优化非线性函数的方法。它既适用于小型数据集,也适用于大型复杂数据集。它也很容易实现,因为它遵循一个简单明了的数学方法。

梯度下降算法的一个重要部分是学习率。这个参数决定了该算法调整参数的速度。较高的学习率会导致算法发散或震荡,而不是收敛到局部最小点。因此,选择一个合适的学习率是梯度下降优化过程的一个重要部分。

梯度下降被广泛用于机器学习应用中,如神经网络或支持向量机。它也被用于其他领域,如搜索引擎或自然语言处理。