Giảm dần độ dốc là một cách tiếp cận thuật toán lặp lại được sử dụng trong Machine Learning để giảm thiểu hàm mục tiêu hoặc chi phí. Nó được sử dụng để tối ưu hóa các tham số của một mô hình, chẳng hạn như trong Hồi quy giảm dần độ dốc, để đạt được điểm tối đa hoặc tối thiểu đối với tập hợp các tham số. Nói cách khác, mục tiêu là tìm các tham số làm giảm thiểu hàm chi phí.

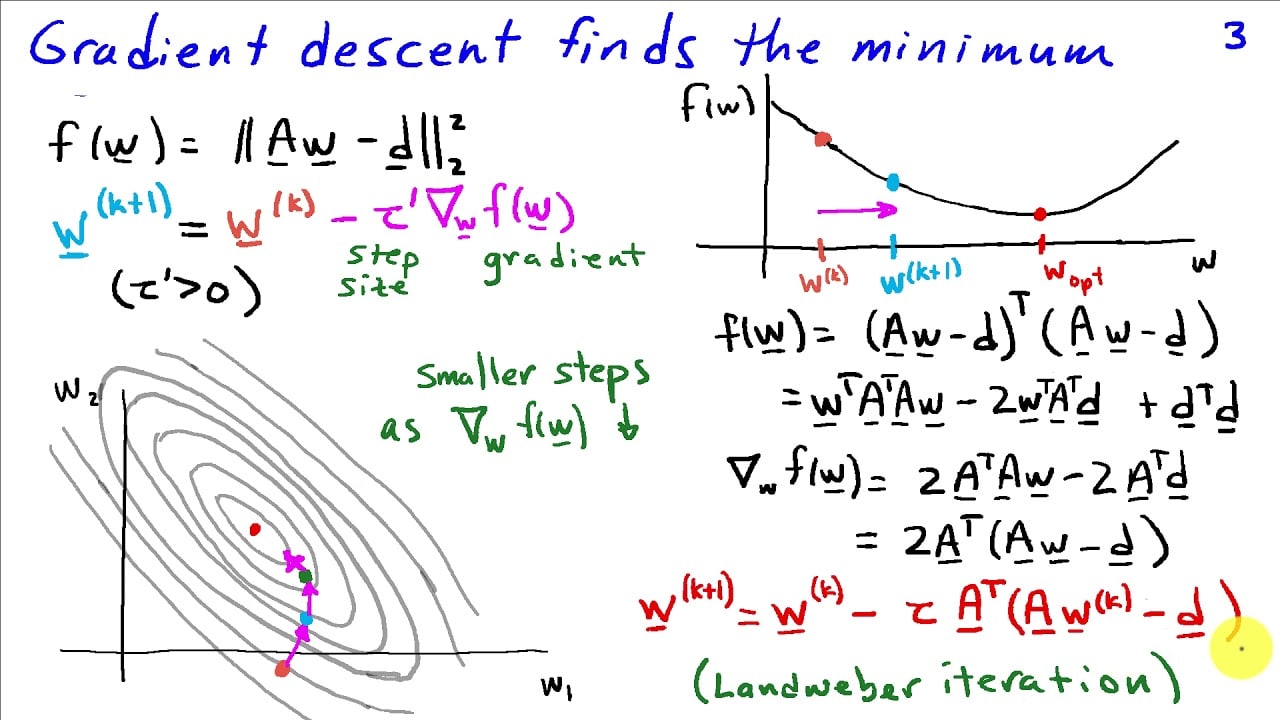

Giảm dần độ dốc hoạt động bằng cách tính toán độ dốc của hàm tại mỗi điểm, sau đó điều chỉnh các tham số cho phù hợp. Độ dốc là đạo hàm của hàm chi phí đối với tham số. Nếu đạo hàm có giá trị âm thì tham số tối ưu sẽ giảm. Điều ngược lại xảy ra khi đạo hàm có giá trị dương. Khi thuật toán đi theo gradient giảm dần, cuối cùng nó sẽ đạt đến điểm có gradient bằng 0. Tại thời điểm đó, các tham số sẽ đạt đến điểm tối thiểu cục bộ.

Nhìn chung, gradient Descent là một phương pháp rất phù hợp để tối ưu hóa các hàm phi tuyến. Nó hoạt động trong các tập dữ liệu nhỏ cũng như các tập dữ liệu lớn phức tạp. Nó cũng dễ thực hiện vì nó tuân theo cách tiếp cận toán học đơn giản.

Một phần quan trọng của thuật toán Giảm dần độ dốc là tốc độ học tập. Tham số này xác định thuật toán sẽ điều chỉnh các tham số nhanh như thế nào. Tốc độ học cao hơn có thể khiến thuật toán phân kỳ hoặc dao động thay vì hội tụ về điểm cực tiểu cục bộ. Do đó, việc lựa chọn tốc độ học thích hợp là một phần quan trọng của quá trình tối ưu hóa Giảm dần độ dốc.

Giảm dần độ dốc được sử dụng rộng rãi trong các ứng dụng Machine Learning như Mạng thần kinh hoặc Máy vectơ hỗ trợ. Nó cũng được sử dụng trong các lĩnh vực khác như Công cụ tìm kiếm hoặc Xử lý ngôn ngữ tự nhiên.