近接ポリシー最適化 (PPO) は、人工知能で使用されるポリシー勾配強化学習アルゴリズムのファミリーです。 2017 年に John Schulman、Filip Wolski、Prafulla Dhariwal、AlecRadford、Oleg Klimov によって発明されました。 PPO は、トレーニング手順を簡素化し、スピードアップする自然なポリシー勾配の近似です。

PPO アルゴリズムは、確率的ポリシー勾配を適用して、期待される報酬を改善し、トレーニングを安定させる方向にエージェントのポリシーを更新することによって機能します。これは、近位ポリシー最適化と呼ばれる最適化手法を使用して行われます。これにより、エージェントは、現在の最良の小さな領域内のアクション価値関数のみを考慮することによって、アクション価値関数のパラメーターを調整できます。これにより、特定のトレーニング ステップで小さな変更のみが行われるようになり、より簡単で安定した学習が可能になります。

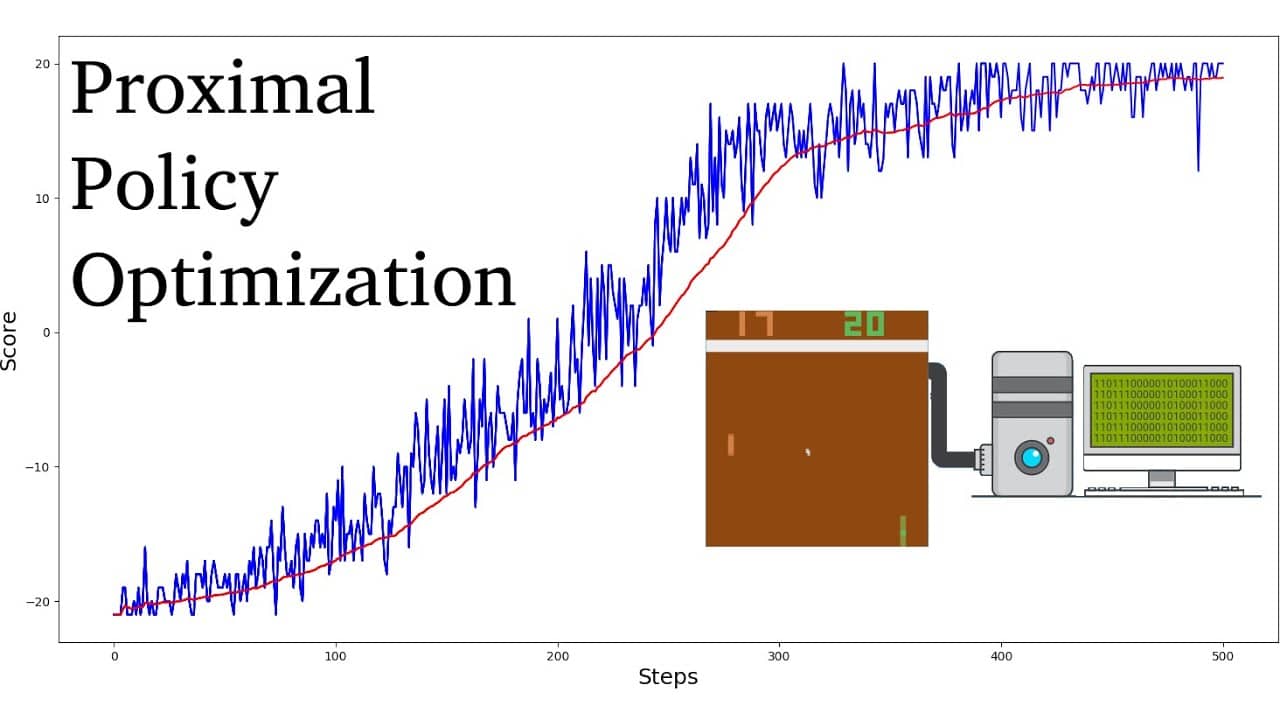

他の強化学習アルゴリズムと比較して、PPO は収束に達するまでに必要なサンプルと反復が少なく、同時により高い最適な報酬値も達成できることが示されています。さらに、PPO アルゴリズムに必要なハイパーパラメータの調整は、他の強化学習アルゴリズムに比べて大幅に簡単です。

一般に、PPO アルゴリズムは、信頼領域ポリシー最適化 (TRPO) などの他のポリシー勾配アルゴリズムよりもサンプル効率が高いと考えられています。また、より安定していることでも知られており、実際のアプリケーションに適しています。そのため、PPO アルゴリズムはロボット工学、ビデオ ゲームのプレイ、自動運転の分野で大きな成功を収めています。