Tối ưu hóa chính sách gần nhất (PPO) là một nhóm các thuật toán học tăng cường độ dốc chính sách được sử dụng trong trí tuệ nhân tạo. Nó được phát minh vào năm 2017 bởi John Schulman, Filip Wolski, Prafulla Dhariwal, AlecRadford và Oleg Klimov. PPO là sự xấp xỉ của độ dốc chính sách tự nhiên giúp đơn giản hóa và tăng tốc quy trình đào tạo.

Các thuật toán PPO hoạt động bằng cách áp dụng gradient chính sách ngẫu nhiên để cập nhật chính sách của tổng đài viên theo hướng cải thiện phần thưởng mong đợi và ổn định quá trình đào tạo. Điều này được thực hiện bằng cách sử dụng một kỹ thuật tối ưu hóa được gọi là tối ưu hóa chính sách gần nhất, cho phép tác nhân điều chỉnh các tham số của hàm giá trị hành động của mình bằng cách chỉ xem xét các hàm giá trị hành động trong một vùng nhỏ của giá trị tốt nhất hiện tại. Điều này đảm bảo rằng chỉ những thay đổi nhỏ được thực hiện trong bất kỳ bước đào tạo cụ thể nào, cho phép việc học dễ dàng và ổn định hơn.

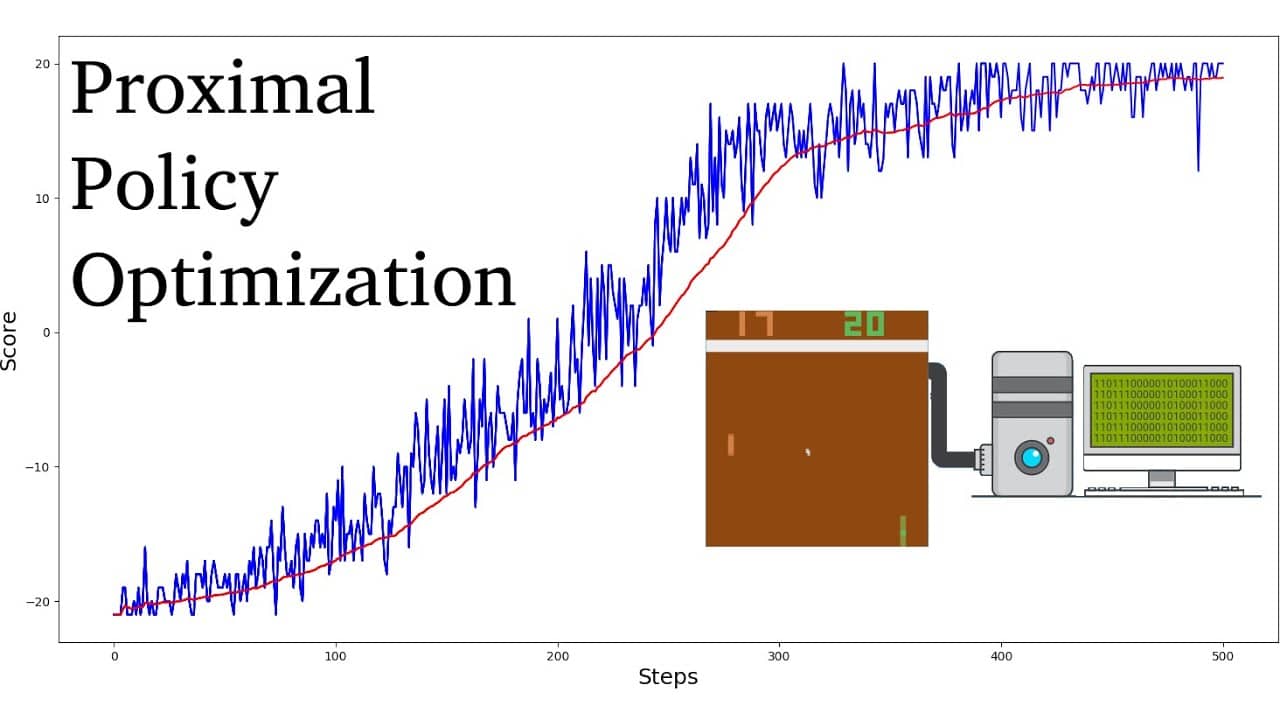

So với các thuật toán học tăng cường khác, PPO đã được chứng minh là yêu cầu ít mẫu và số lần lặp hơn để đạt được sự hội tụ, đồng thời đạt được giá trị phần thưởng tối ưu cao hơn. Hơn nữa, việc điều chỉnh các siêu tham số cần thiết cho thuật toán PPO đơn giản hơn đáng kể so với các thuật toán học tăng cường khác.

Các thuật toán PPO thường được coi là có hiệu quả lấy mẫu cao hơn các thuật toán gradient chính sách khác, chẳng hạn như Tối ưu hóa chính sách vùng tin cậy (TRPO). Chúng cũng được biết là ổn định hơn, khiến chúng phù hợp với các ứng dụng trong thế giới thực. Do đó, thuật toán PPO đã đạt được thành công lớn trong chế tạo robot, chơi trò chơi điện tử và lái xe tự động.