L'optimisation de politique proximale (PPO) est une famille d'algorithmes d'apprentissage par renforcement du gradient de politique utilisés en intelligence artificielle. Elle a été inventée en 2017 par John Schulman, Filip Wolski, Prafulla Dhariwal, AlecRadford et Oleg Klimov. Le PPO est une approximation du gradient de politique naturelle qui simplifie et accélère la procédure d'apprentissage.

Les algorithmes PPO fonctionnent en appliquant un gradient de politique stochastique pour mettre à jour la politique d'un agent dans une direction qui améliore la récompense attendue et stabilise la formation. Pour ce faire, ils utilisent une technique d'optimisation appelée "optimisation proximale de la politique", qui permet à un agent d'ajuster les paramètres de sa fonction action-valeur en ne considérant que les fonctions action-valeur situées dans une petite région de la meilleure fonction actuelle. Cela garantit que seuls de petits changements sont apportés lors d'une étape de formation donnée, ce qui permet un apprentissage plus facile et plus stable.

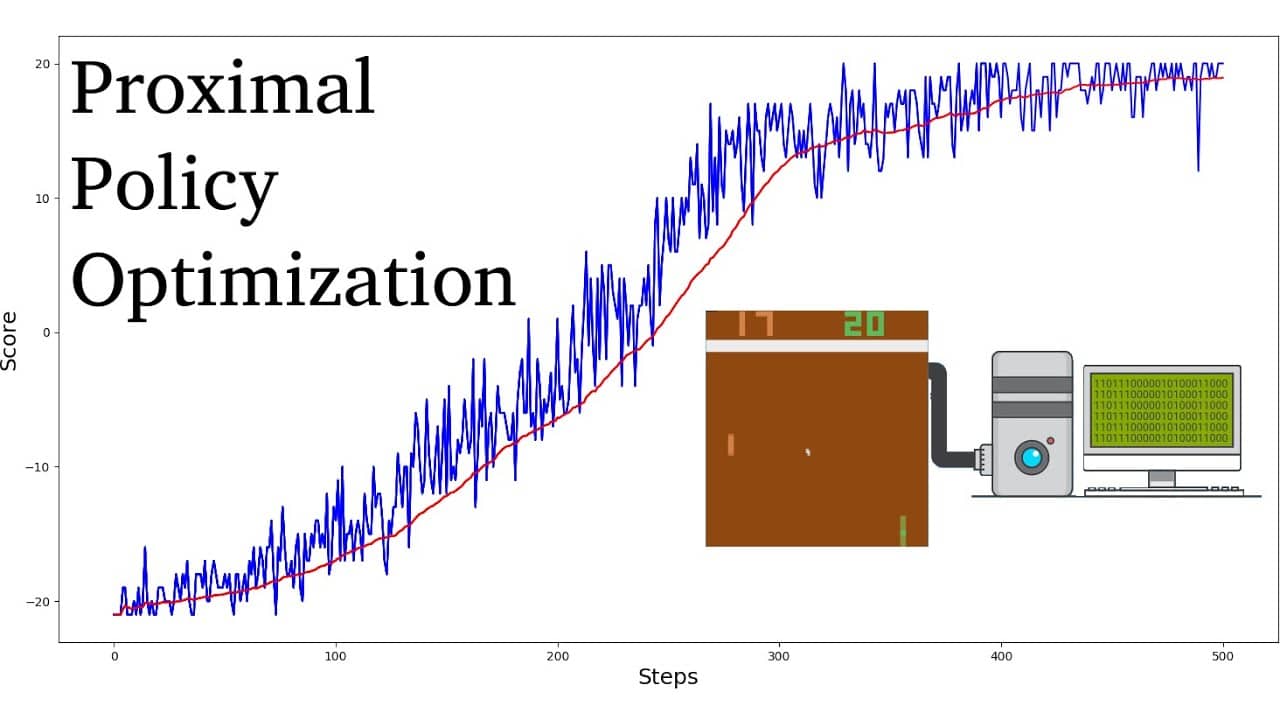

Par rapport à d'autres algorithmes d'apprentissage par renforcement, il a été démontré que le PPO nécessite moins d'échantillons et d'itérations pour atteindre la convergence, tout en obtenant des valeurs de récompense optimales plus élevées. En outre, le réglage des hyperparamètres nécessaires aux algorithmes PPO est nettement plus simple qu'avec d'autres algorithmes d'apprentissage par renforcement.

Les algorithmes PPO sont généralement considérés comme plus efficaces en termes d'échantillonnage que d'autres algorithmes de gradient de politique tels que l'optimisation de la politique de la région de confiance (TRPO). Ils sont également connus pour être plus stables, ce qui les rend adaptés aux applications du monde réel. Ainsi, les algorithmes PPO ont connu un grand succès dans les domaines de la robotique, des jeux vidéo et de la conduite autonome.