Proximal policy optimization (PPO) - это семейство алгоритмов градиентного обучения подкрепления политики, используемых в искусственном интеллекте. Оно было изобретено в 2017 году Джоном Шульманом, Филипом Вольски, Прафуллой Дхаривалом, Алеком Рэдфордом и Олегом Климовым. PPO - это аппроксимация естественного градиента политики, которая упрощает и ускоряет процедуру обучения.

Алгоритмы PPO работают путем применения стохастического градиента политики для обновления политики агента в направлении, которое улучшает ожидаемое вознаграждение и стабилизирует обучение. Для этого используется метод оптимизации, называемый приближенной оптимизацией политики, который позволяет агенту корректировать параметры функции "действие-значение", рассматривая функции "действие-значение" только в пределах небольшой области текущего наилучшего значения. Это гарантирует, что на каждом конкретном шаге обучения вносятся только небольшие изменения, что обеспечивает более легкое и стабильное обучение.

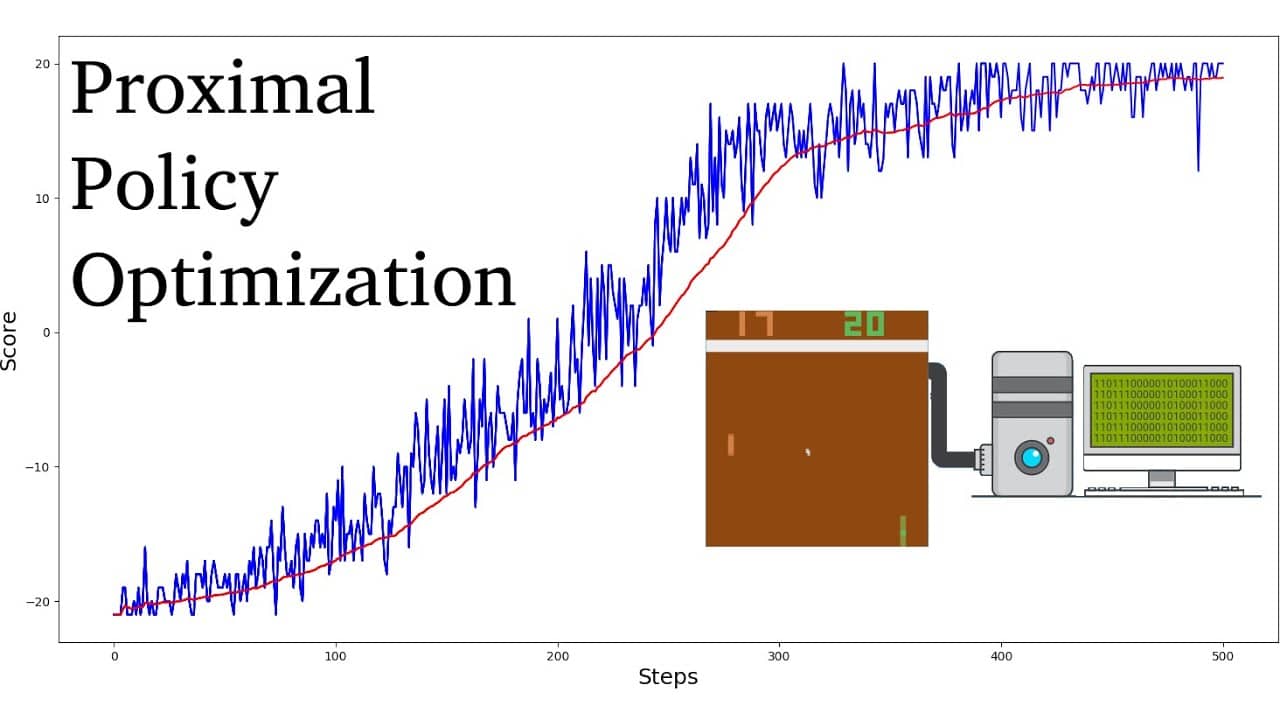

По сравнению с другими алгоритмами обучения с подкреплением, PPO, как было показано, требует меньшего количества проб и итераций для достижения сходимости, при этом достигая более высоких оптимальных значений вознаграждения. Кроме того, настройка гиперпараметров, необходимых для алгоритмов PPO, значительно проще, чем для других алгоритмов обучения с подкреплением.

Алгоритмы PPO обычно считаются более эффективными с точки зрения выборки, чем другие градиентные алгоритмы политики, такие как Trust Region Policy Optimization (TRPO). Они также известны как более стабильные, что делает их пригодными для применения в реальном мире. Поэтому алгоритмы PPO пользуются большим успехом в робототехнике, видеоиграх и автономном вождении.