समीपस्थ नीति अनुकूलन (पीपीओ) कृत्रिम बुद्धिमत्ता में उपयोग किए जाने वाले नीति ढाल सुदृढीकरण शिक्षण एल्गोरिदम का एक परिवार है। इसका आविष्कार 2017 में जॉन शुलमैन, फिलिप वोल्स्की, प्रफुल्ल धारीवाल, एलेकरेडफोर्ड और ओलेग क्लिमोव ने किया था। पीपीओ प्राकृतिक नीति ढाल का एक अनुमान है जो प्रशिक्षण प्रक्रिया को सरल और तेज करता है।

पीपीओ एल्गोरिदम एक एजेंट की नीति को उस दिशा में अद्यतन करने के लिए स्टोकेस्टिक नीति ढाल लागू करके काम करता है जो अपेक्षित इनाम में सुधार करता है और प्रशिक्षण को स्थिर करता है। यह समीपस्थ नीति अनुकूलन नामक एक अनुकूलन तकनीक का उपयोग करके किया जाता है जो एक एजेंट को वर्तमान सर्वोत्तम के एक छोटे से क्षेत्र के भीतर केवल क्रिया-मूल्य कार्यों पर विचार करके अपने क्रिया-मूल्य फ़ंक्शन के मापदंडों को समायोजित करने में सक्षम बनाता है। यह सुनिश्चित करता है कि किसी भी प्रशिक्षण चरण में केवल छोटे बदलाव किए जाएं, जिससे सीखना आसान और अधिक स्थिर हो सके।

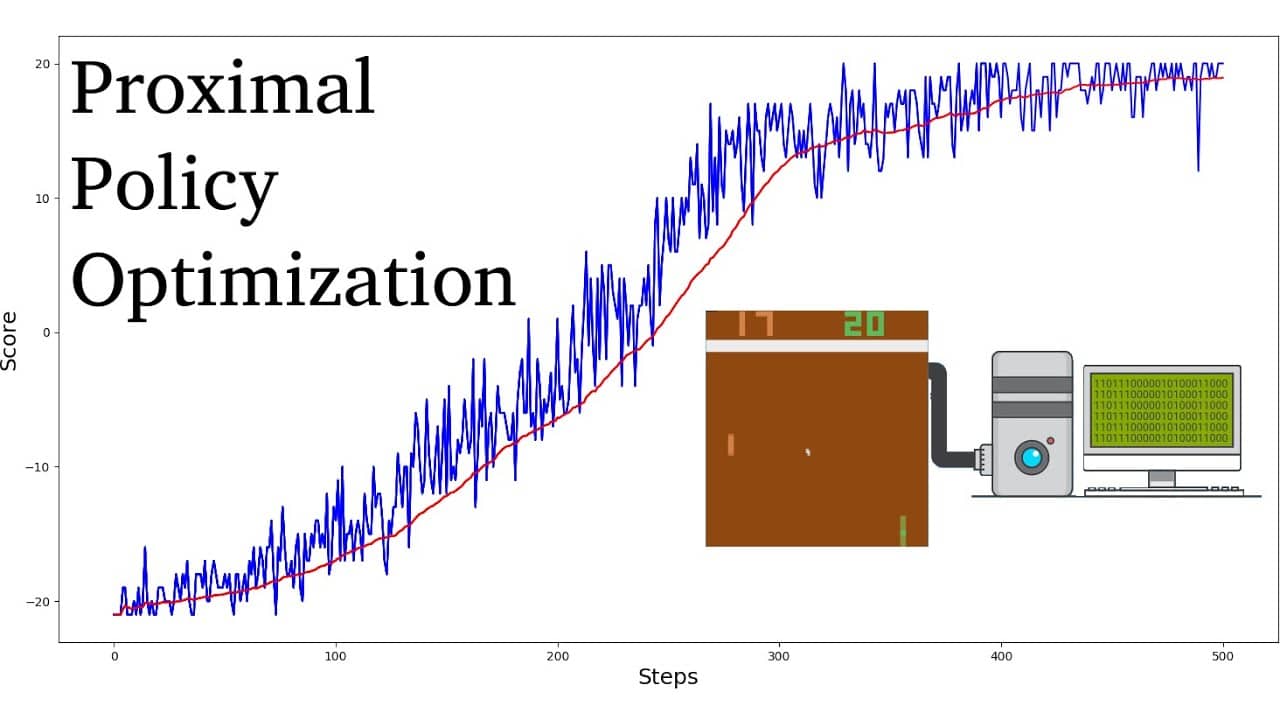

अन्य सुदृढीकरण सीखने के एल्गोरिदम की तुलना में, पीपीओ को अभिसरण तक पहुंचने के लिए कम नमूनों और पुनरावृत्तियों की आवश्यकता होती है, जबकि उच्च इष्टतम इनाम मूल्य भी प्राप्त होता है। इसके अलावा, पीपीओ एल्गोरिदम के लिए आवश्यक हाइपरपैरामीटर की ट्यूनिंग अन्य सुदृढीकरण सीखने वाले एल्गोरिदम की तुलना में काफी सरल है।

पीपीओ एल्गोरिदम को आमतौर पर ट्रस्ट रीजन पॉलिसी ऑप्टिमाइजेशन (टीआरपीओ) जैसे अन्य पॉलिसी ग्रेडिएंट एल्गोरिदम की तुलना में अधिक नमूना-कुशल माना जाता है। उन्हें अधिक स्थिर भी माना जाता है, जो उन्हें वास्तविक दुनिया के अनुप्रयोगों के लिए उपयुक्त बनाता है। जैसे, पीपीओ एल्गोरिदम को रोबोटिक्स, वीडियो गेम खेलने और स्वायत्त ड्राइविंग में बड़ी सफलता मिली है।