近端策略优化(PPO)是人工智能中使用的策略梯度强化学习算法家族。它是由John Schulman、Filip Wolski、Prafulla Dhariwal、AlecRadford和Oleg Klimov于2017年发明的。PPO是对自然政策梯度的一种近似,它简化并加快了训练程序。

PPO算法通过应用随机政策梯度来更新代理人的政策,以提高预期奖励和稳定训练的方向。这是通过使用一种称为近似策略优化的优化技术来实现的,该技术使代理人能够通过只考虑当前最佳区域内的行动价值函数来调整其行动价值函数的参数。这确保了在任何给定的训练步骤中只做小的改变,使学习更容易和更稳定。

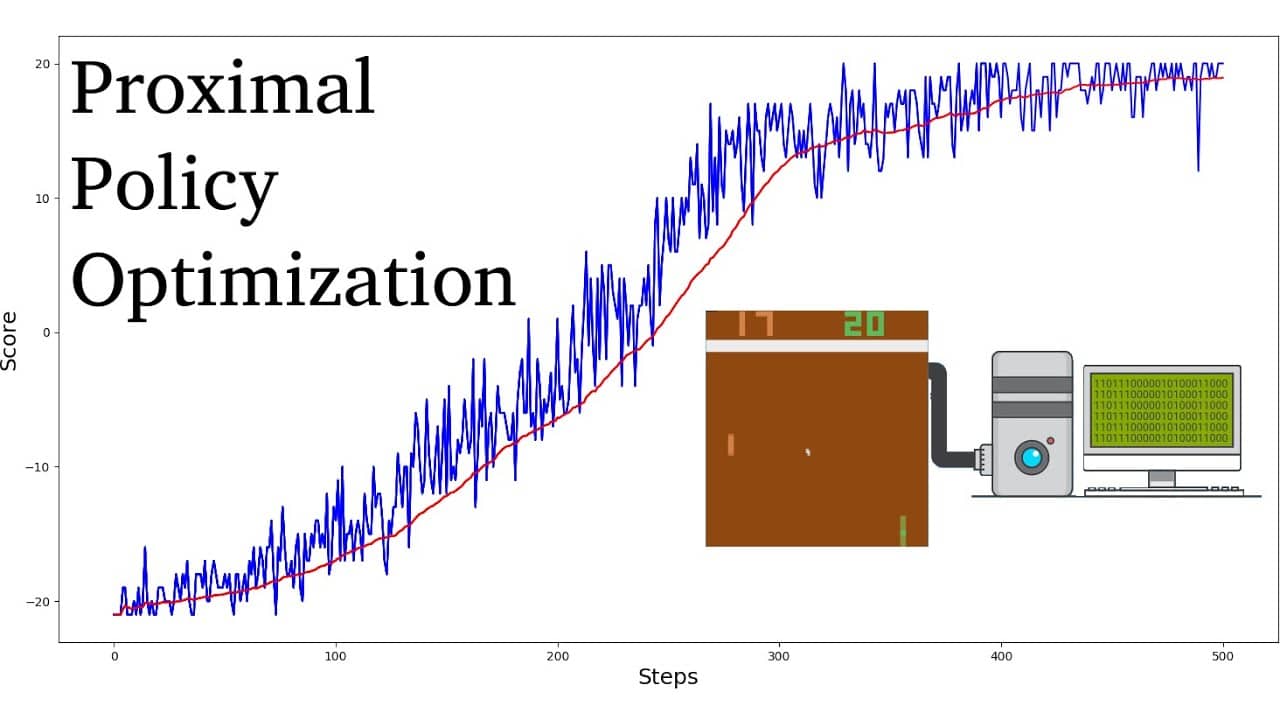

与其他强化学习算法相比,PPO已被证明需要更少的样本和迭代来达到收敛,同时也能获得更高的最优奖励值。此外,PPO算法所需的超参数调整也比其他强化学习算法简单得多。

PPO算法通常被认为比其他政策梯度算法(如信任区域政策优化(TRPO))更具样本效率。它们也被认为是更稳定的,使它们适合于现实世界的应用。因此,PPO算法在机器人技术、视频游戏和自动驾驶方面取得了巨大的成功。