A otimização de política proximal (PPO) é uma família de algoritmos de aprendizado por reforço de gradiente de política usados em inteligência artificial. Foi inventada em 2017 por John Schulman, Filip Wolski, Prafulla Dhariwal, AlecRadford e Oleg Klimov. O PPO é uma aproximação do gradiente de política natural que simplifica e acelera o procedimento de treinamento.

Os algoritmos PPO funcionam aplicando um gradiente de política estocástica para atualizar a política de um agente em uma direção que melhore a recompensa esperada e estabilize o treinamento. Isso é feito por meio de uma técnica de otimização chamada otimização de política proximal, que permite que um agente ajuste os parâmetros de sua função de ação-valor considerando apenas as funções de ação-valor dentro de uma pequena região da melhor atual. Isso garante que apenas pequenas alterações sejam feitas em uma determinada etapa de treinamento, permitindo um aprendizado mais fácil e estável.

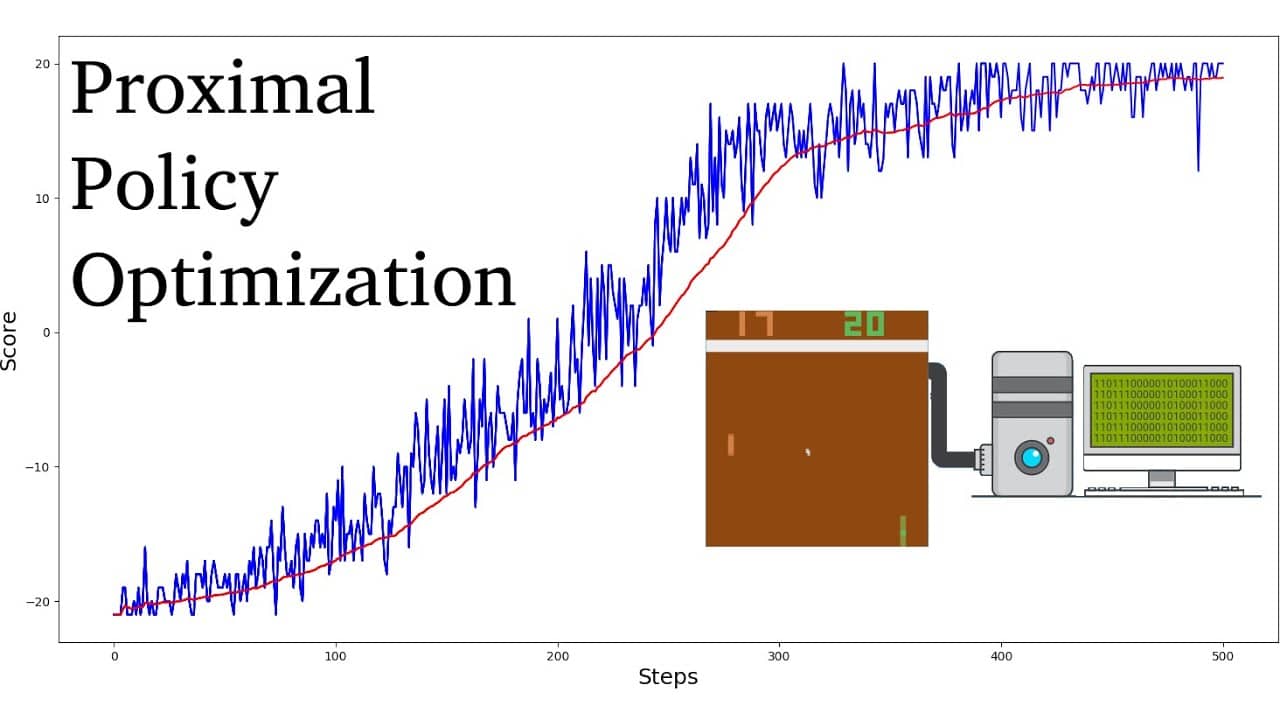

Em comparação com outros algoritmos de aprendizagem por reforço, o PPO demonstrou exigir menos amostras e iterações para atingir a convergência e, ao mesmo tempo, alcançar valores de recompensa ideais mais altos. Além disso, o ajuste dos hiperparâmetros necessários para os algoritmos PPO é significativamente mais simples do que com outros algoritmos de aprendizagem por reforço.

Em geral, os algoritmos PPO são considerados mais eficientes em termos de amostragem do que outros algoritmos de gradiente de política, como o TRPO (Trust Region Policy Optimization). Eles também são conhecidos por serem mais estáveis, o que os torna adequados para aplicações no mundo real. Dessa forma, os algoritmos PPO obtiveram grande sucesso em robótica, jogos de videogame e direção autônoma.