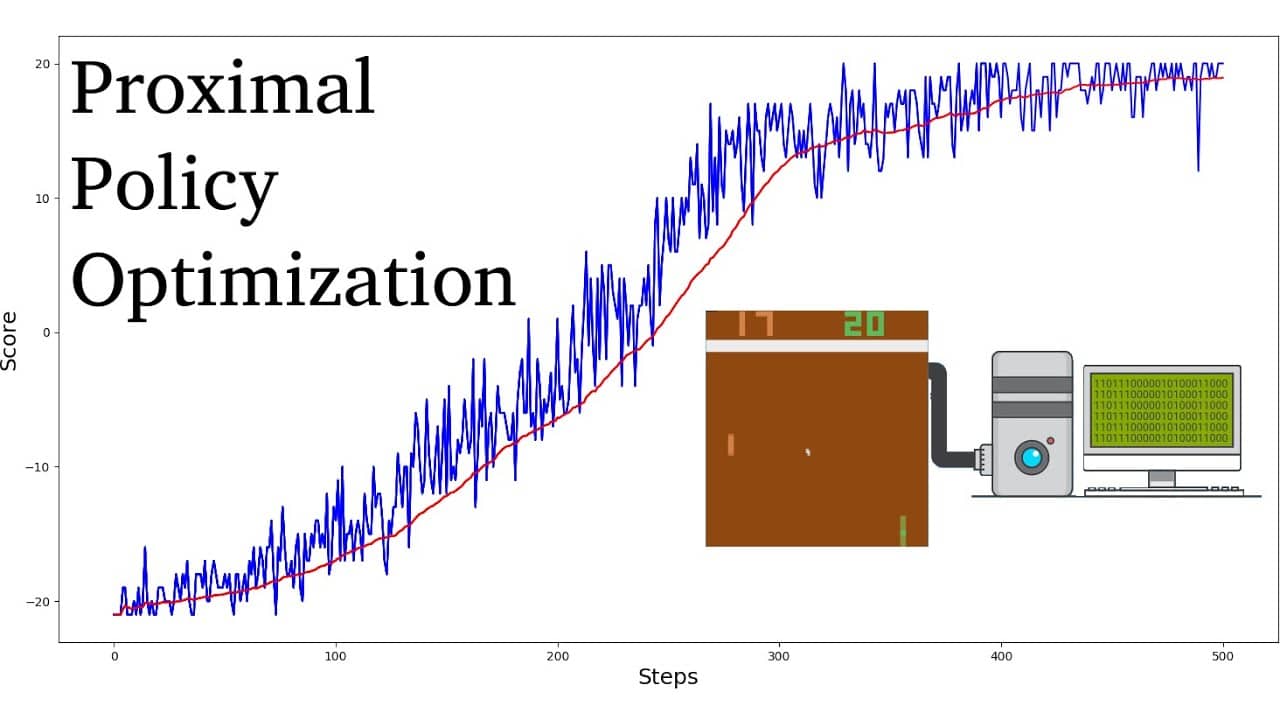

Proximal politika optimizasyonu (PPO), yapay zekada kullanılan bir politika gradyan takviye öğrenme algoritmaları ailesidir. John Schulman, Filip Wolski, Prafulla Dhariwal, AlecRadford ve Oleg Klimov tarafından 2017 yılında icat edilmiştir. PPO, eğitim prosedürünü basitleştiren ve hızlandıran doğal politika gradyanının bir yaklaşımıdır.

PPO algoritmaları, bir ajanın politikasını beklenen ödülü iyileştiren ve eğitimi stabilize eden bir yönde güncellemek için stokastik bir politika gradyanı uygulayarak çalışır. Bu, bir ajanın eylem-değer fonksiyonunun parametrelerini yalnızca mevcut en iyinin küçük bir bölgesi içindeki eylem-değer fonksiyonlarını dikkate alarak ayarlamasını sağlayan proksimal politika optimizasyonu adı verilen bir optimizasyon tekniği kullanılarak yapılır. Bu, herhangi bir eğitim adımında yalnızca küçük değişiklikler yapılmasını sağlayarak daha kolay ve daha istikrarlı öğrenmeye olanak tanır.

Diğer takviyeli öğrenme algoritmalarına kıyasla, PPO'nun yakınsamaya ulaşmak için daha az örnek ve iterasyon gerektirdiği ve aynı zamanda daha yüksek optimal ödül değerleri elde ettiği gösterilmiştir. Ayrıca, PPO algoritmaları için gerekli hiperparametrelerin ayarlanması, diğer takviyeli öğrenme algoritmalarına göre önemli ölçüde daha basittir.

PPO algoritmalarının genellikle Güven Bölgesi Politika Optimizasyonu (TRPO) gibi diğer politika gradyan algoritmalarından daha örnek verimli olduğu düşünülmektedir. Ayrıca daha kararlı oldukları bilinmektedir, bu da onları gerçek dünya uygulamaları için uygun hale getirir. Bu nedenle, PPO algoritmaları robotik, video oyunu oynama ve otonom sürüşte büyük başarı elde etmiştir.