Proximal policy optimization (PPO) to rodzina gradientowych algorytmów uczenia ze wzmocnieniem wykorzystywanych w sztucznej inteligencji. Została wynaleziona w 2017 roku przez Johna Schulmana, Filipa Wolskiego, Prafullę Dhariwal, Aleca Radforda i Olega Klimova. PPO jest przybliżeniem naturalnego gradientu polityki, który upraszcza i przyspiesza procedurę uczenia.

Algorytmy PPO działają poprzez zastosowanie stochastycznego gradientu polityki w celu aktualizacji polityki agenta w kierunku, który poprawia oczekiwaną nagrodę i stabilizuje szkolenie. Odbywa się to za pomocą techniki optymalizacji zwanej proksymalną optymalizacją polityki, która umożliwia agentowi dostosowanie parametrów jego funkcji działania-wartości poprzez uwzględnienie tylko funkcji działania-wartości w małym regionie bieżącego najlepszego. Gwarantuje to, że tylko niewielkie zmiany są wprowadzane w danym kroku szkolenia, co pozwala na łatwiejsze i bardziej stabilne uczenie się.

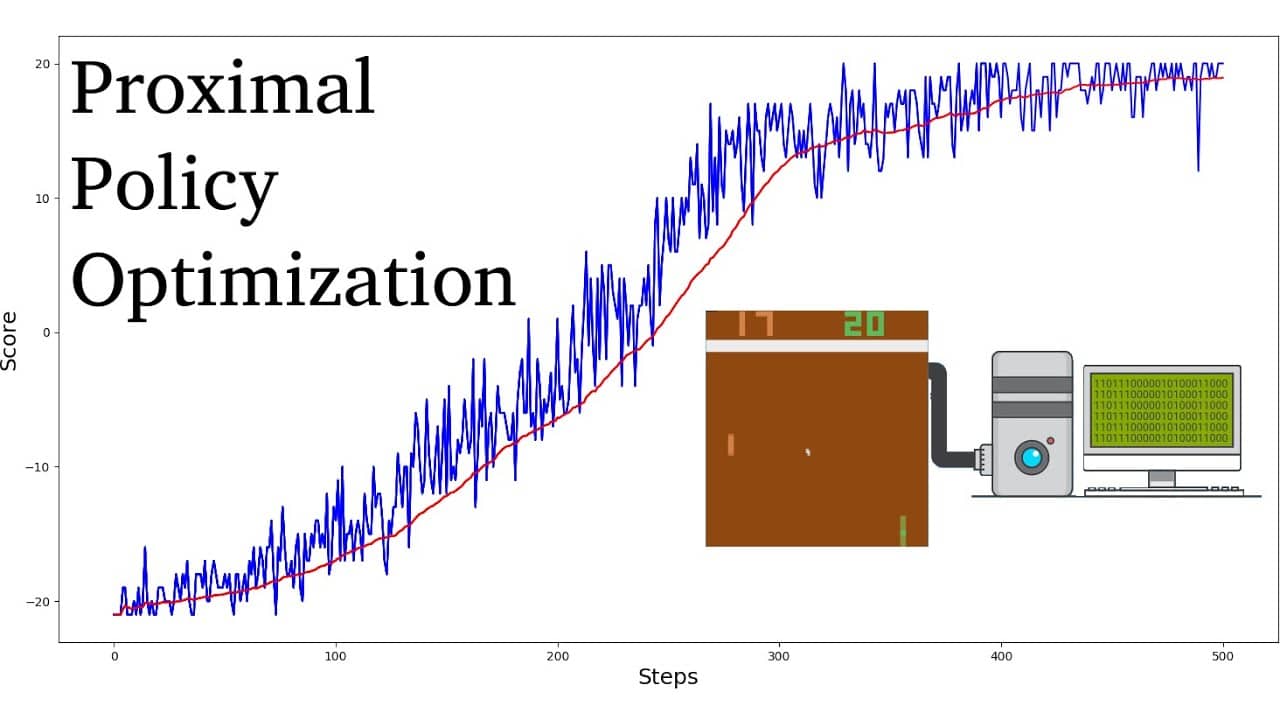

W porównaniu do innych algorytmów uczenia ze wzmocnieniem, wykazano, że PPO wymaga mniejszej liczby próbek i iteracji, aby osiągnąć zbieżność, jednocześnie osiągając wyższe optymalne wartości nagród. Co więcej, dostrajanie hiperparametrów niezbędnych dla algorytmów PPO jest znacznie prostsze niż w przypadku innych algorytmów uczenia ze wzmocnieniem.

Algorytmy PPO są ogólnie uważane za bardziej wydajne pod względem próbkowania niż inne algorytmy gradientu polityki, takie jak Trust Region Policy Optimization (TRPO). Wiadomo również, że są one bardziej stabilne, dzięki czemu nadają się do zastosowań w świecie rzeczywistym. W związku z tym algorytmy PPO odniosły wielki sukces w robotyce, grach wideo i autonomicznej jeździe.