Proximální optimalizace politiky (PPO) je rodina algoritmů učení zesílení gradientu politiky používaných v umělé inteligenci. Vynalezli jej v roce 2017 John Schulman, Filip Wolski, Prafulla Dhariwal, AlecRadford a Oleg Klimov. PPO je aproximací gradientu přirozené politiky, který zjednodušuje a urychluje tréninkový proces.

Algoritmy PPO fungují tak, že aplikují gradient stochastické politiky k aktualizaci politiky agenta směrem, který zlepšuje očekávanou odměnu a stabilizuje trénink. To se provádí pomocí optimalizační techniky nazývané proximální optimalizace politiky, která agentovi umožňuje upravit parametry své funkce akční hodnoty tím, že zohlední pouze funkce akční hodnoty v rámci malé oblasti současných nejlepších. Tím je zajištěno, že v každém daném tréninkovém kroku jsou provedeny pouze malé změny, což umožňuje snadnější a stabilnější učení.

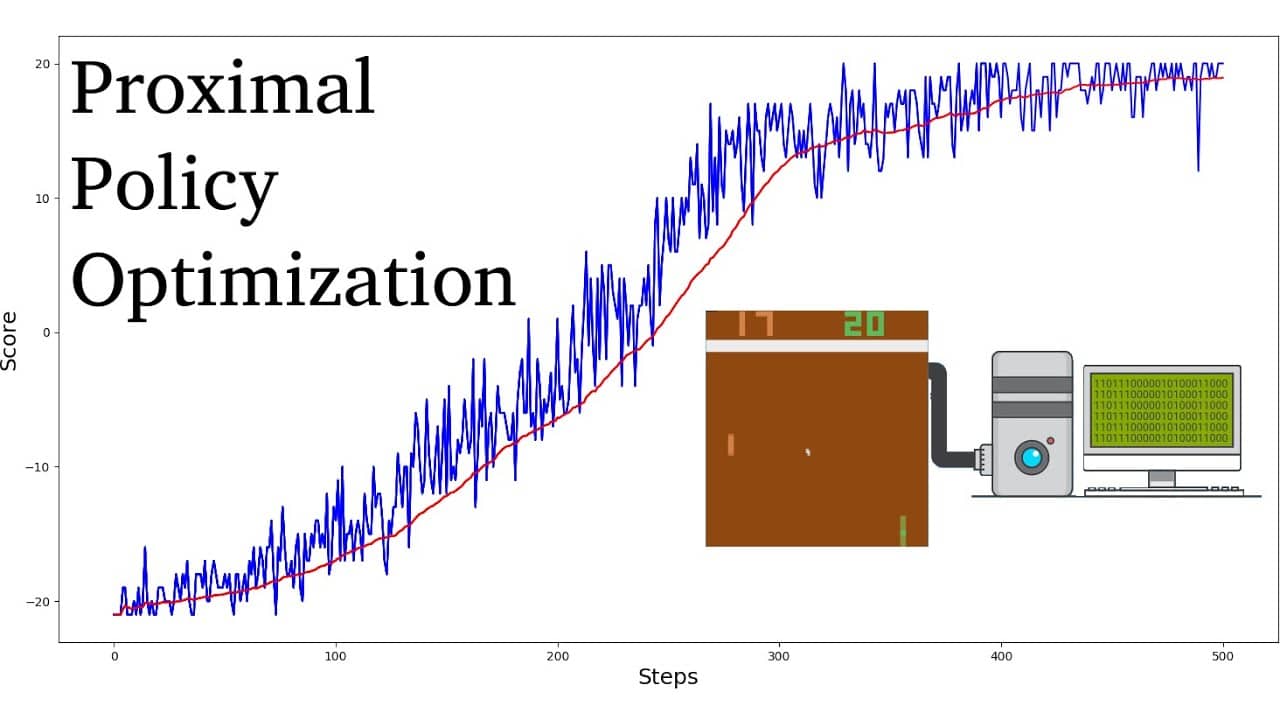

Ve srovnání s jinými algoritmy učení zesílení se ukázalo, že PPO vyžaduje méně vzorků a iterací k dosažení konvergence a zároveň dosahuje vyšších optimálních hodnot odměny. Kromě toho je ladění hyperparametrů nezbytných pro algoritmy PPO výrazně jednodušší než u jiných algoritmů učení zesílení.

Algoritmy PPO jsou obecně považovány za vzorově efektivnější než jiné algoritmy gradientu politiky, jako je Trust Region Policy Optimization (TRPO). Je také známo, že jsou stabilnější, takže jsou vhodné pro aplikace v reálném světě. Algoritmy PPO jako takové zaznamenaly velký úspěch v robotice, hraní videoher a autonomním řízení.