Doğal dil işlemede tokenleştirme, belirli bir metin parçasını, metni ayrıştırmak ve değerlendirmek için kullanılabilecek daha küçük bireysel birimlere bölmek için kullanılan bir işlemdir. Doğal dil işlemede (NLP), belirli bir metni anlamını analiz etmek için kelimeler, ifadeler ve semboller gibi temel parçalarına ayırmayı amaçlayan önemli bir görevdir. Tokenizasyon ayrıca makine çevirisi ve metinden konuşmaya sistemlerinde de kullanılır.

Jetonlama işlemi, metni farklı jetonlara veya kelimeler, sayılar ve noktalama işaretleri gibi metin parçalarına ayırmayı içerir. Jetonlar daha sonra konuşma parçası etiketleme, adlandırılmış varlık tanıma ve duygu analizi gibi daha ileri işlemler için temel oluşturur. Tokenizasyon ayrıca metin belgelerinden veya veritabanlarından bilgi arama ve alma sürecini de basitleştirir.

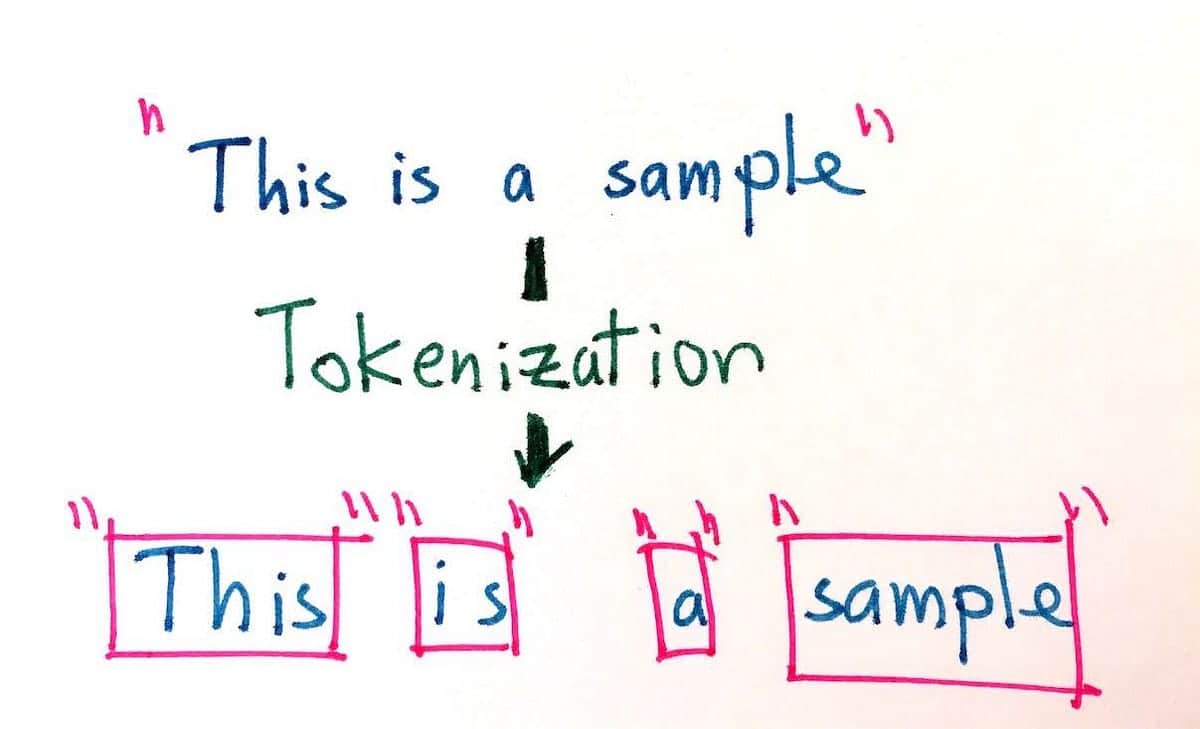

Jetonlaştırmanın amacı, daha hassas analiz yapabilmek için uzun metin parçalarını en küçük birimlerine ayırmaktır. Jetonlama, kelime sınırlarına, cümlelere, paragraflara, sayılara ve karakterlere göre bölme gibi çeşitli şekillerde gerçekleştirilebilir. Örneğin, "Köpek hızla koştu" cümlesi aşağıdaki belirteçlere ayrılabilir: "The, dog, ran, quickly". Buna ek olarak, aynı cümle göz önüne alındığında, tokenizasyon byte, Unicode ve ASCII gibi farklı kodlama türlerini de barındırabilir.

Dijital içeriğin hızla büyümesi nedeniyle tokenizasyon kullanımı son yıllarda giderek daha önemli hale gelmiştir. Tokenizasyon, büyük miktarda doğal dil verisinin aranmasını ve kullanılmasını kolaylaştırır ve özellikle doğal dil işleme alanında yapay zekanın geliştirilmesi ve iyileştirilmesi için gereklidir. Birçok arama motoru ve uygulama, ürettikleri sonuçların doğruluğunu artırmak için tokenlaştırmayı kullanır. Ayrıca, tokenizasyon birçok konuşma tanıma sisteminin önemli bir bileşenidir ve sözlü girdiyi daha kolay tanımlanabilen ve kategorize edilebilen birimlere ayırmak için kullanılır.

Yazılı ve sözlü dilin anlaşılmasına yardımcı olarak, tokenizasyon doğal dil veritabanlarının karmaşıklığını azaltmak için kullanılabilir, kullanıcıların ilgili bilgileri çıkarmasını kolaylaştırır ve daha iyi bir kullanıcı deneyimi yaratır. Bu nedenle, tokenizasyon hem doğal dil işleme hem de modern arama motoru uygulamaları için paha biçilmez bir araçtır.