Токенизация в обработке естественного языка - это процесс, используемый для разделения заданного фрагмента текста на более мелкие отдельные единицы, которые могут быть использованы для разбора и оценки текста. Это важная задача в обработке естественного языка (NLP), цель которой - разбить заданный текст на основные части, такие как слова, фразы и символы, чтобы проанализировать его смысл. Токенизация также используется в системах машинного перевода и преобразования текста в речь.

Процесс токенизации предполагает разделение текста на различные лексемы, или фрагменты текста, такие как слова, цифры и знаки препинания. Затем токены служат основой для дальнейшей обработки, такой как тегирование части речи, распознавание именованных сущностей и анализ настроения. Токенизация также упрощает процесс поиска и извлечения информации из текстовых документов или баз данных.

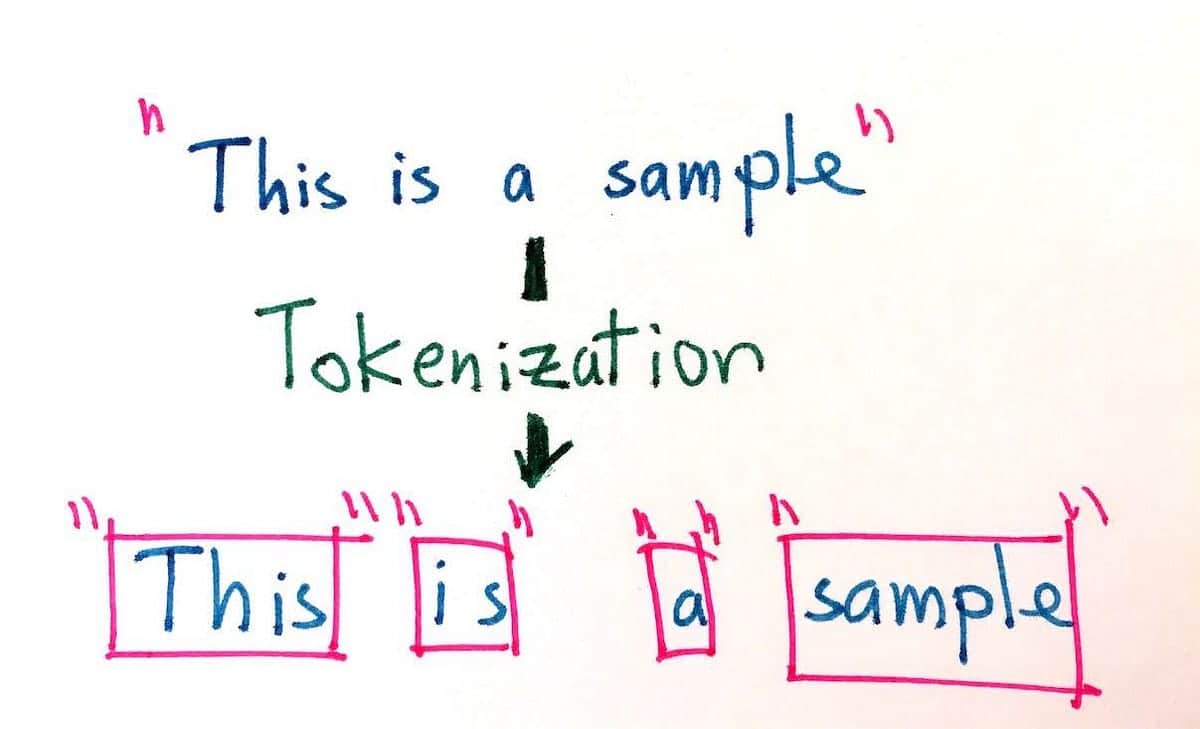

Цель токенизации - разбить длинные фрагменты текста на мельчайшие единицы для более точного анализа. Токенизация может осуществляться различными способами, например, делением на границы слов, предложений, абзацев, чисел и символов. Например, предложение "Собака быстро побежала" можно разделить на следующие лексемы: "The, dog, ran, quickly". Кроме того, для одного и того же предложения токенизация может учитывать различные типы кодировки, такие как байт, Юникод и ASCII.

В последние годы использование токенизации становится все более важным в связи с бурным ростом цифрового контента. Токенизация облегчает поиск и использование больших объемов данных на естественном языке, и она необходима для развития и совершенствования искусственного интеллекта, особенно в области обработки естественного языка. Многие поисковые системы и приложения используют токенизацию для повышения точности выдаваемых ими результатов. Кроме того, токенизация является ключевым компонентом многих систем распознавания речи, в которых она используется для разделения устного ввода на единицы, которые легче идентифицировать и классифицировать.

Помогая понимать письменную и устную речь, токенизация может использоваться для снижения сложности баз данных естественного языка, облегчая извлечение релевантной информации и создавая лучший пользовательский опыт. Таким образом, токенизация является бесценным инструментом как для обработки естественного языка, так и для современных поисковых систем.