Tokenisasi dalam pemrosesan bahasa alami adalah proses yang digunakan untuk membagi sepotong teks tertentu menjadi unit-unit individual yang lebih kecil yang dapat digunakan untuk mengurai dan mengevaluasi teks. Ini adalah tugas penting dalam pemrosesan bahasa alami (NLP) yang bertujuan untuk memecah teks tertentu menjadi bagian-bagian mendasar, seperti kata, frasa, dan simbol, untuk menganalisis maknanya. Tokenisasi juga digunakan dalam terjemahan mesin dan sistem text-to-speech.

Proses tokenisasi melibatkan pemisahan teks menjadi token yang berbeda, atau potongan teks, seperti kata, angka, dan tanda baca. Token tersebut kemudian berfungsi sebagai dasar untuk pemrosesan lebih lanjut, seperti penandaan part-of-speech, pengenalan entitas bernama, dan analisis sentimen. Tokenisasi juga menyederhanakan proses pencarian dan pengambilan informasi dari dokumen teks atau database.

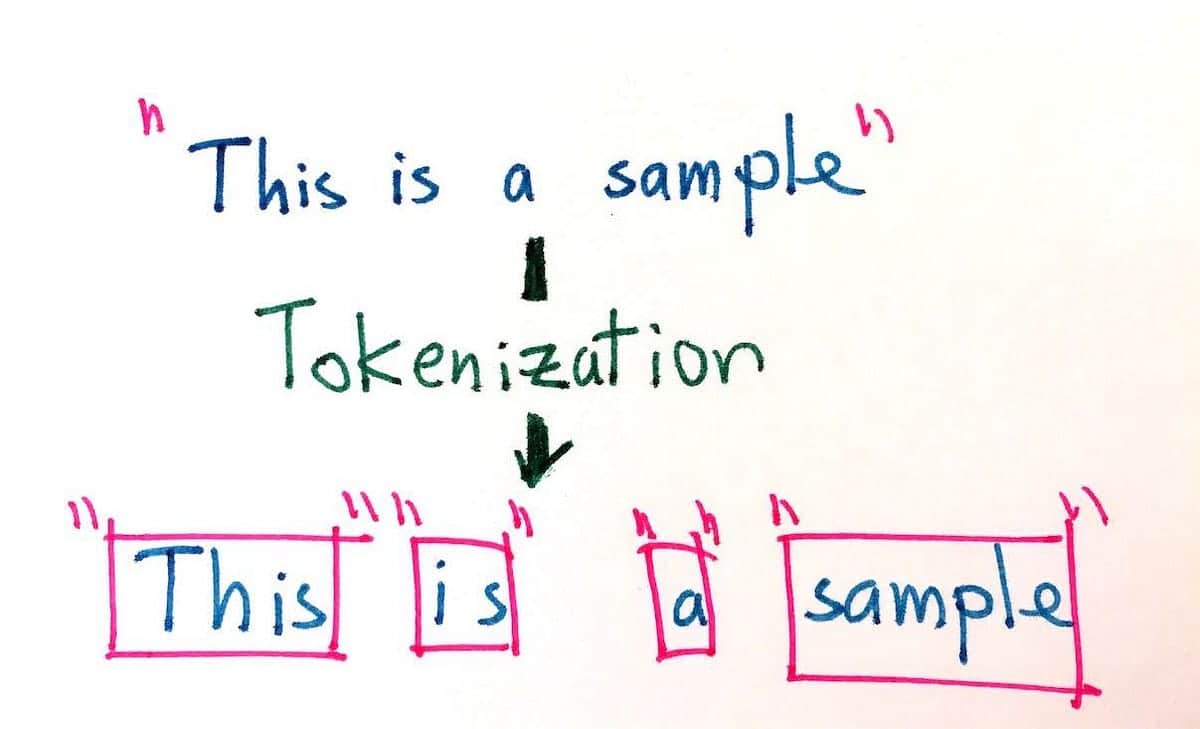

Tujuan dari tokenisasi adalah untuk memecah potongan teks yang panjang menjadi unit-unit terkecil untuk memungkinkan analisis yang lebih tepat. Tokenisasi dapat dilakukan dengan berbagai cara, seperti membagi berdasarkan batasan kata, kalimat, paragraf, angka, dan karakter. Misalnya, kalimat “Anjing berlari dengan cepat” dapat ditoken menjadi token berikut: “Anjing, lari, cepat”. Selain itu, dengan kalimat yang sama, tokenisasi juga dapat mengakomodasi berbagai jenis pengkodean, seperti byte, Unicode, dan ASCII.

Penggunaan tokenisasi menjadi semakin penting dalam beberapa tahun terakhir karena ledakan pertumbuhan konten digital. Tokenisasi mempermudah pencarian dan penggunaan data bahasa alami dalam jumlah besar, dan ini penting untuk pengembangan dan peningkatan kecerdasan buatan, khususnya di bidang pemrosesan bahasa alami. Banyak mesin pencari dan aplikasi menggunakan tokenisasi untuk meningkatkan keakuratan hasil yang mereka hasilkan. Selain itu, tokenisasi adalah komponen kunci dari banyak sistem pengenalan suara, yang digunakan untuk memecah masukan lisan menjadi unit-unit yang lebih mudah diidentifikasi dan dikategorikan.

Dengan membantu pemahaman bahasa tertulis dan lisan, tokenisasi dapat digunakan untuk mengurangi kompleksitas database bahasa alami, sehingga memudahkan pengguna untuk mengekstrak informasi yang relevan dan menciptakan pengalaman pengguna yang lebih baik. Dengan demikian, tokenisasi adalah alat yang sangat berharga baik untuk pemrosesan bahasa alami maupun aplikasi mesin pencari modern.