Tokenizace ve zpracování přirozeného jazyka je proces používaný k rozdělení daného kusu textu na menší jednotlivé jednotky, které lze použít k analýze a vyhodnocení textu. Je to důležitý úkol při zpracování přirozeného jazyka (NLP), jehož cílem je rozdělit daný text na jeho základní části, jako jsou slova, fráze a symboly, za účelem analýzy jeho významu. Tokenizace se také používá v systémech strojového překladu a převodu textu na řeč.

Proces tokenizace zahrnuje oddělení textu do různých tokenů nebo částí textu, jako jsou slova, čísla a interpunkční znaménka. Tokeny pak slouží jako základ pro další zpracování, jako je slovní značkování, rozpoznávání pojmenovaných entit a analýza sentimentu. Tokenizace také zjednodušuje proces vyhledávání a získávání informací z textových dokumentů nebo databází.

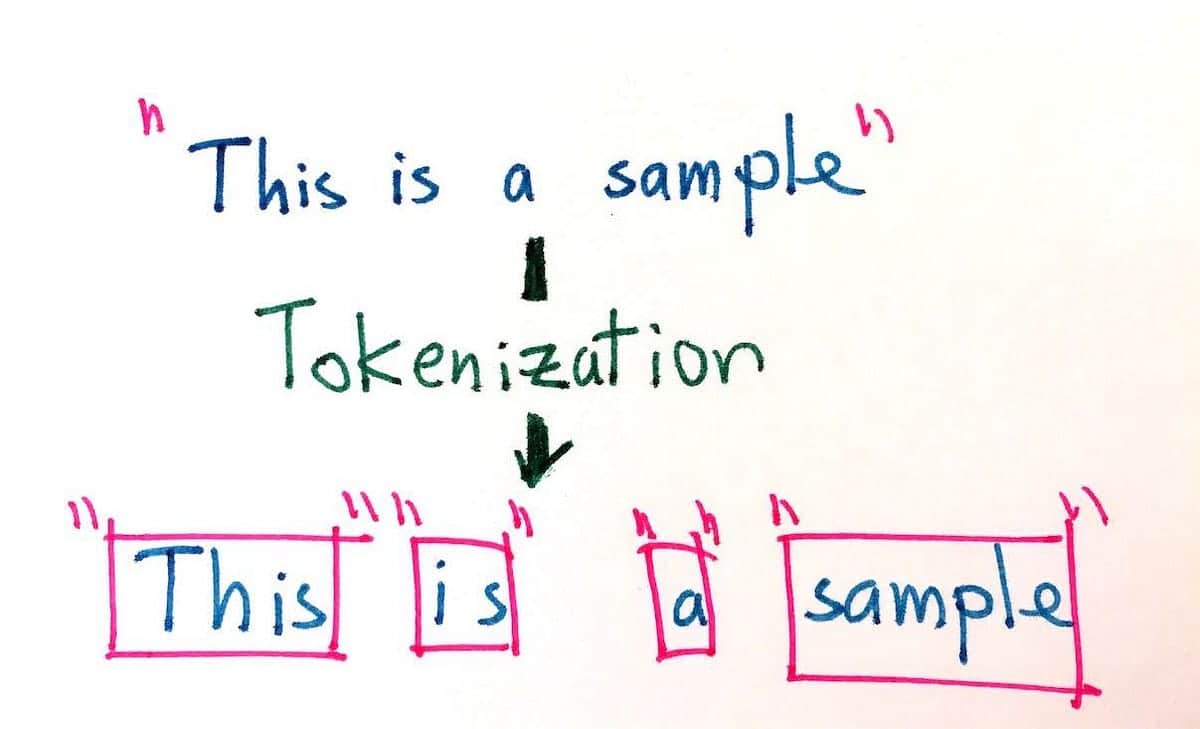

Cílem tokenizace je rozdělit dlouhé kusy textu na nejmenší jednotky a umožnit tak přesnější analýzu. Tokenizace může být provedena různými způsoby, jako je rozdělení podle hranic slov, vět, odstavců, čísel a znaků. Například věta „Pes běžel rychle“ by mohla být tokenizována do následujících žetonů: „Pes, běžel, rychle“. Kromě toho, vzhledem ke stejné větě, může tokenizace také pojmout různé typy kódování, jako je byte, Unicode a ASCII.

Použití tokenizace se v posledních letech stalo stále důležitějším kvůli explozivnímu růstu digitálního obsahu. Tokenizace usnadňuje vyhledávání a používání velkého množství dat přirozeného jazyka a je nezbytná pro rozvoj a zlepšování umělé inteligence, zejména v oblasti zpracování přirozeného jazyka. Mnoho vyhledávačů a aplikací používá tokenizaci ke zlepšení přesnosti výsledků, které generují. Kromě toho je tokenizace klíčovou součástí mnoha systémů rozpoznávání řeči, ve kterých se používá k rozdělení mluveného vstupu do jednotek, které lze snadněji identifikovat a kategorizovat.

Tím, že napomáhá porozumění psanému a mluvenému jazyku, lze tokenizaci použít ke snížení složitosti databází přirozeného jazyka, což uživatelům usnadňuje extrahování relevantních informací a vytváří lepší uživatelskou zkušenost. Tokenizace je jako taková neocenitelným nástrojem jak pro zpracování přirozeného jazyka, tak pro moderní aplikace vyhledávačů.