BLEU 점수("이중 언어 평가 연구"의 약어)는 자연어 텍스트의 자동 기계 번역을 평가하는 방법입니다. 2002년에 도입된 이래 컴퓨터 과학 분야에서 가장 널리 사용되는 자동 번역 품질 측정 방법 중 하나가 되었습니다. BLEU는 기계 번역된 텍스트와 참조 번역을 비교하고 둘 사이의 공통 단어 비율을 계산하는 방식으로 작동합니다.

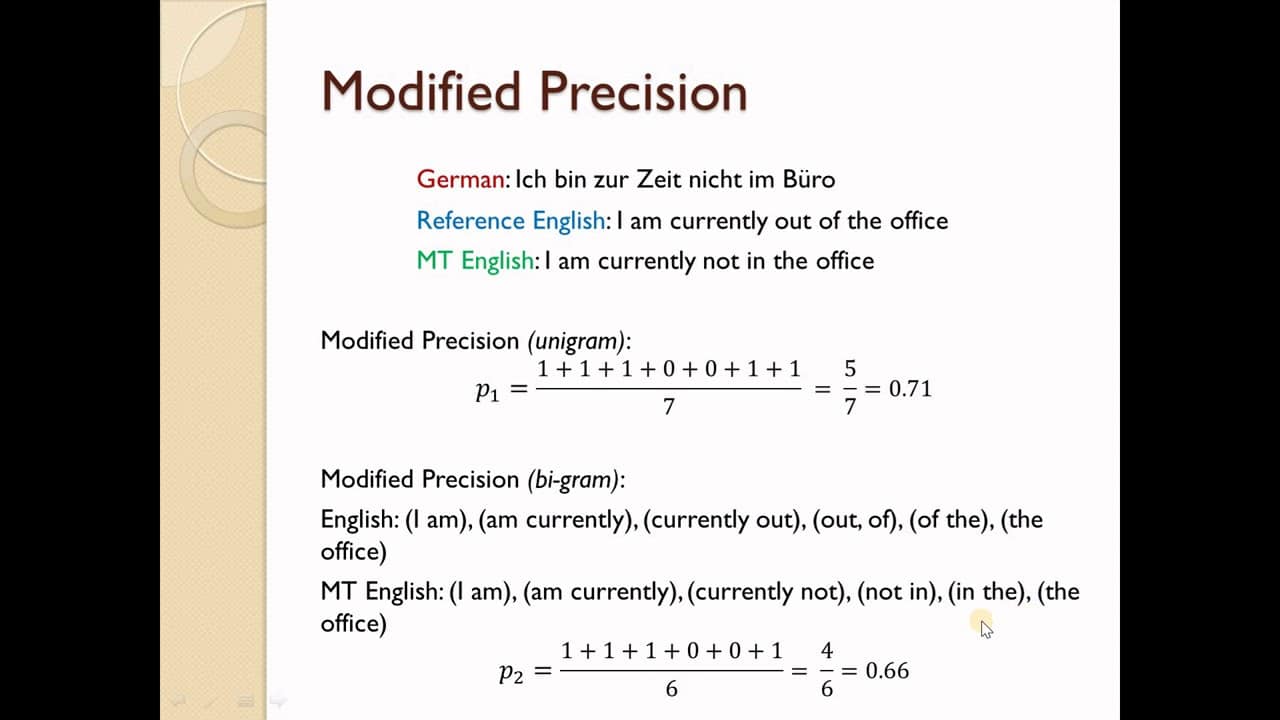

BLEU 알고리즘은 기계 번역 텍스트에서 참조 번역과 일치하는 단어 수를 세고 이를 기계 번역 텍스트의 총 단어 수로 나누어 계산한 정밀도 점수를 산출합니다. BLEU 점수가 높을수록 번역 품질이 우수하고, 점수가 낮을수록 품질이 낮음을 나타냅니다. 이후 다양한 종류의 번역을 보다 정확하게 반영하기 위해 점수 시스템을 더욱 개선했습니다.

BLEU 점수는 자연어 처리 및 컴퓨터 지원 언어 학습과 같은 기계 번역과 관련된 작업에서 특히 중요합니다. 이 점수는 연구자들이 알고리즘의 성능을 이해하는 데 도움이 되고 새로운 자동 번역 알고리즘을 평가하는 데 유용한 벤치마크를 제공할 수 있습니다. 또한 미주 기계 번역 협회 및 기계 번역 컨퍼런스에서 주최하는 대회와 같은 대회에서 일반적으로 사용됩니다.

전반적으로 BLEU 점수는 자동 번역 서비스의 성능을 측정하는 데 사용되는 중요한 평가 방법입니다. 연구자들이 기계 번역의 정확성과 효율성을 더 잘 이해하고 개선하는 데 도움이 될 뿐만 아니라 프로그래밍 경진대회에서 객관적인 평가 지표를 제공하는 데 중요한 도구입니다.