La distillazione della conoscenza è un processo di trasferimento di informazioni e conoscenze da una fonte a un'altra. Può essere utilizzata per creare nuovi modelli di apprendimento automatico distillando quelli esistenti o per trasferire la conoscenza da sistemi esperti a sistemi inesperti. Si riferisce anche alla pratica di trasferire la conoscenza, come regole o modelli, da una fonte originale a sistemi meno potenti e con meno risorse.

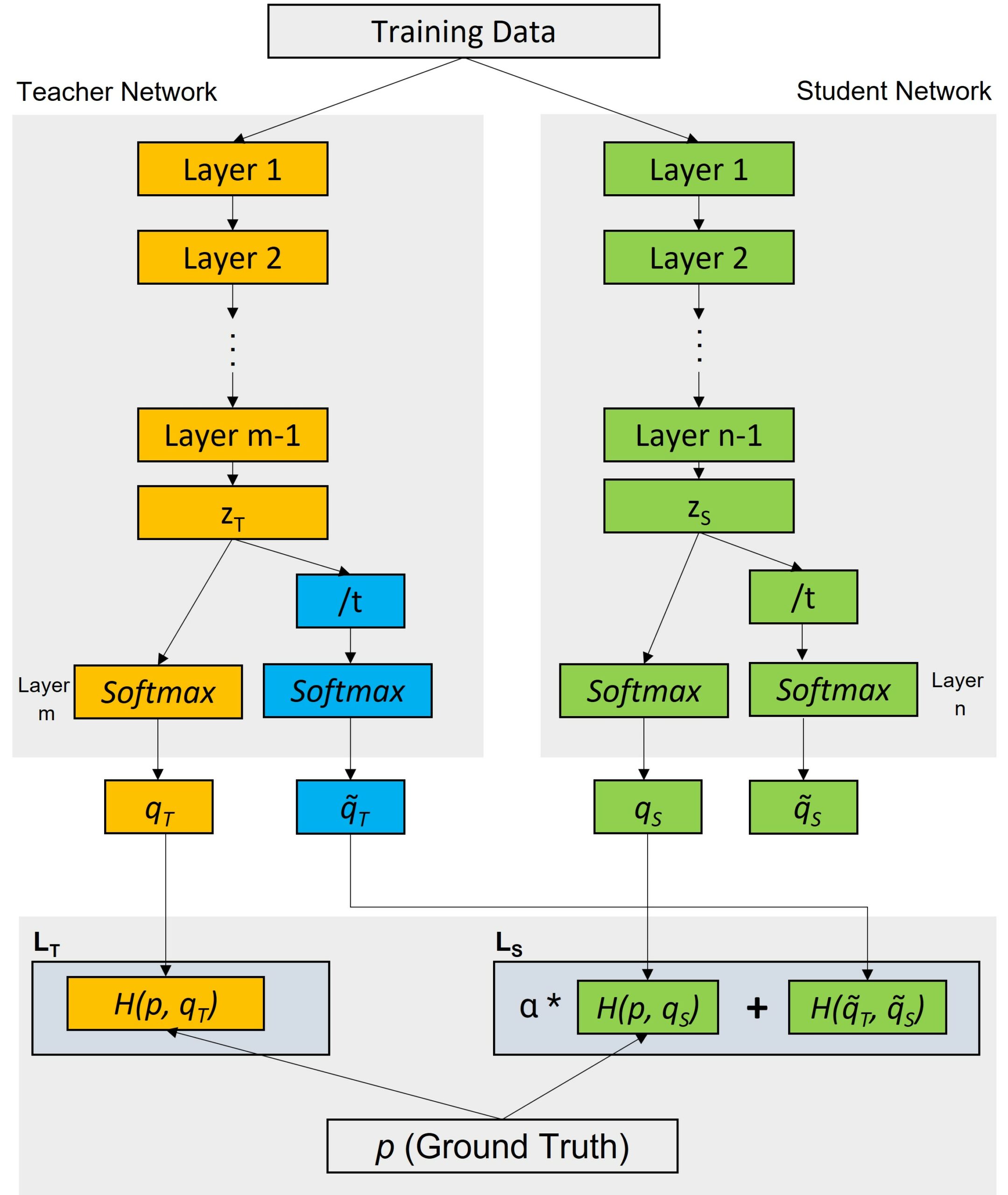

I processi di distillazione della conoscenza possono prevedere due fasi principali: un modello "insegnante" produce una versione attenuata dei dati, che viene poi utilizzata per addestrare il modello "studente". La distillazione della conoscenza può aiutare a risolvere il problema dell'over-fitting, quando il modello è eccessivamente specializzato e non funziona bene con i nuovi dati. Il modello "insegnante" produce una visione probabilistica dei dati per dare allo studente un'idea di quanto sia incerto rispetto a ogni previsione. Durante l'addestramento del modello "studente", al posto delle etichette effettive vengono utilizzati dei soft target, migliorando così le prestazioni di generalizzazione del modello studente.

La distillazione della conoscenza viene utilizzata sia nell'apprendimento supervisionato che in quello non supervisionato. Nell'apprendimento supervisionato, la distillazione della conoscenza aiuta a ridurre i costi computazionali dell'addestramento dei modelli trasferendo la conoscenza tra diverse architetture. Ad esempio, la distillazione della conoscenza può essere utilizzata per comprimere i modelli con annotazioni costose, mantenendo l'accuratezza. Nell'apprendimento non supervisionato, la distillazione della conoscenza suggerisce la condivisione dei parametri tra più fonti con relazioni diverse per contribuire a migliorare la capacità del modello di generare rappresentazioni multiple dei dati.

La distillazione della conoscenza può essere implementata con diverse tecniche. Un approccio comune è quello "basato sui suggerimenti", che consiste nel fornire al modello dello studente informazioni limitate sull'output desiderato. Un'altra tecnica, quella del "fattore di dissolvenza", viene utilizzata per distribuire la conoscenza dall'insegnante allo studente riducendo lentamente l'influenza del primo nel tempo.

Nel complesso, la distillazione della conoscenza è uno strumento potente per trasferire informazioni complesse da una fonte a sistemi o contesti a valle. Trova applicazione sia nell'apprendimento supervisionato che in quello non supervisionato, riducendo i costi di formazione e migliorando l'accuratezza dei modelli.