A destilação de conhecimento é um processo de transferência de informações e conhecimento de uma fonte para outra. Pode ser usado para criar novos modelos de aprendizado de máquina destilando os existentes ou para transmitir conhecimento de sistemas especializados para novatos. Também se refere à prática de transferir conhecimento, como regras ou modelos, de uma fonte original para sistemas menos potentes e com menos recursos.

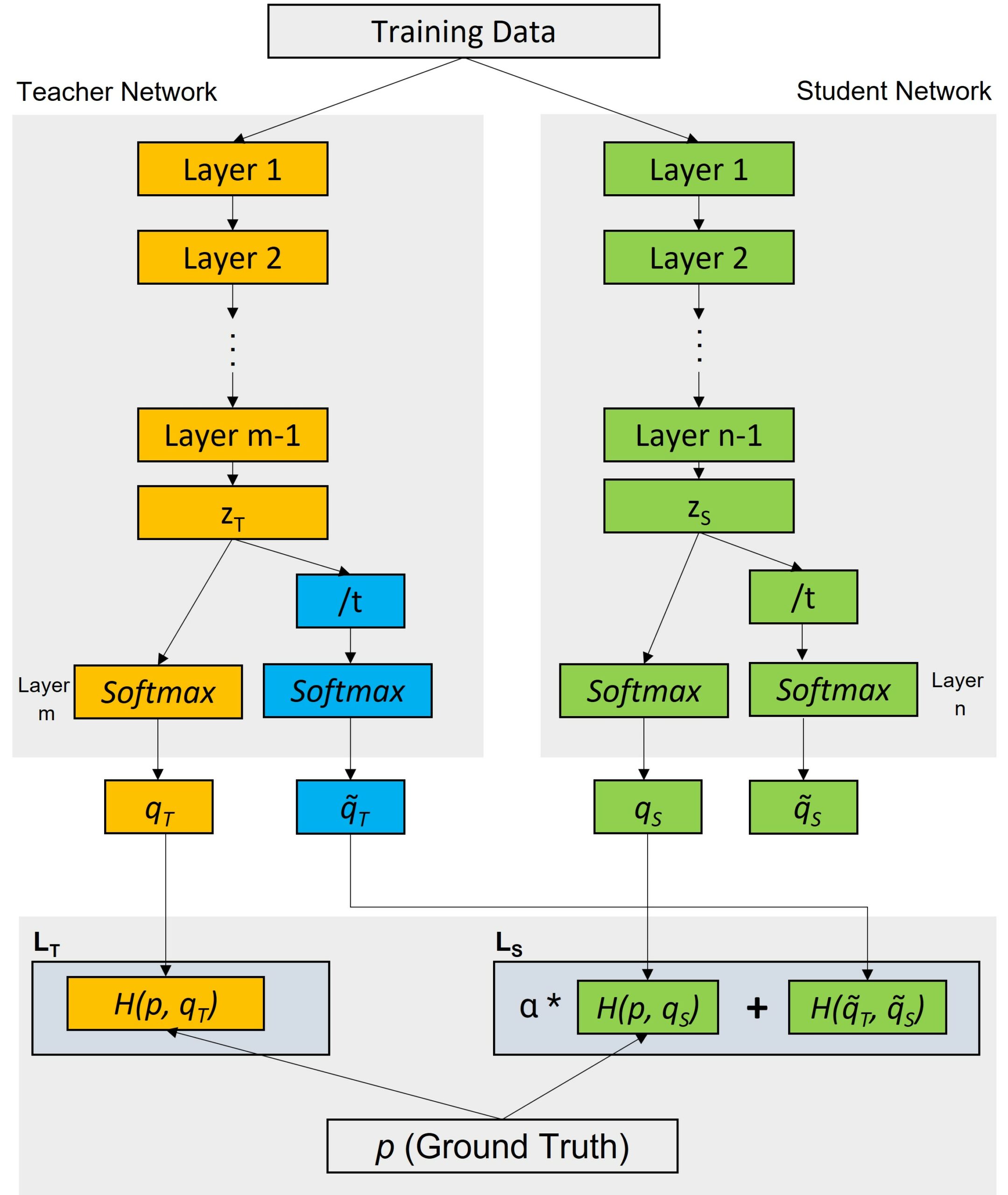

Os processos de destilação do conhecimento podem envolver dois estágios principais: um modelo "professor" produz uma versão suavizada dos dados, que é usada para treinar o modelo "aluno". A destilação do conhecimento pode ajudar a resolver o problema do ajuste excessivo, em que o modelo é excessivamente especializado e tem um desempenho ruim com novos dados. O modelo do "professor" produz uma visão probabilística dos dados para dar ao aluno uma ideia do grau de incerteza com relação a cada previsão. Durante o treinamento do modelo do "aluno", são usados alvos flexíveis em vez dos rótulos reais, o que melhora o desempenho de generalização do modelo do aluno.

A destilação do conhecimento é usada tanto na aprendizagem supervisionada quanto na não supervisionada. Na aprendizagem supervisionada, a destilação de conhecimento ajuda a reduzir os custos computacionais do treinamento de modelos, transferindo conhecimento entre diferentes arquiteturas. Por exemplo, a destilação de conhecimento pode ser usada para compactar modelos com anotações caras e, ao mesmo tempo, manter a precisão. No aprendizado não supervisionado, a destilação do conhecimento sugere o compartilhamento de parâmetros entre várias fontes com relações variadas para ajudar a aumentar a capacidade do modelo de gerar várias representações de dados.

A destilação do conhecimento pode ser implementada com uma variedade de técnicas. Uma abordagem comum é a abordagem "baseada em dicas", que envolve o fornecimento de informações limitadas sobre o resultado desejado para o modelo do aluno. Outra técnica, a técnica de "fator de desvanecimento", é usada para distribuir o conhecimento do professor para o aluno, reduzindo lentamente a influência do primeiro ao longo do tempo.

Em geral, a destilação do conhecimento é uma ferramenta poderosa para transferir informações complexas de uma fonte para sistemas ou contextos downstream. Ela tem aplicações no aprendizado supervisionado e não supervisionado, reduzindo os custos de treinamento e melhorando a precisão dos modelos.