La destilación de conocimientos es un proceso de transferencia de información y conocimientos de una fuente a otra. Puede utilizarse para crear nuevos modelos de aprendizaje automático destilando los existentes, o para impartir conocimientos de sistemas expertos a novatos. También se refiere a la práctica de transferir conocimientos, como reglas o modelos, de una fuente original a sistemas menos potentes y con menos recursos.

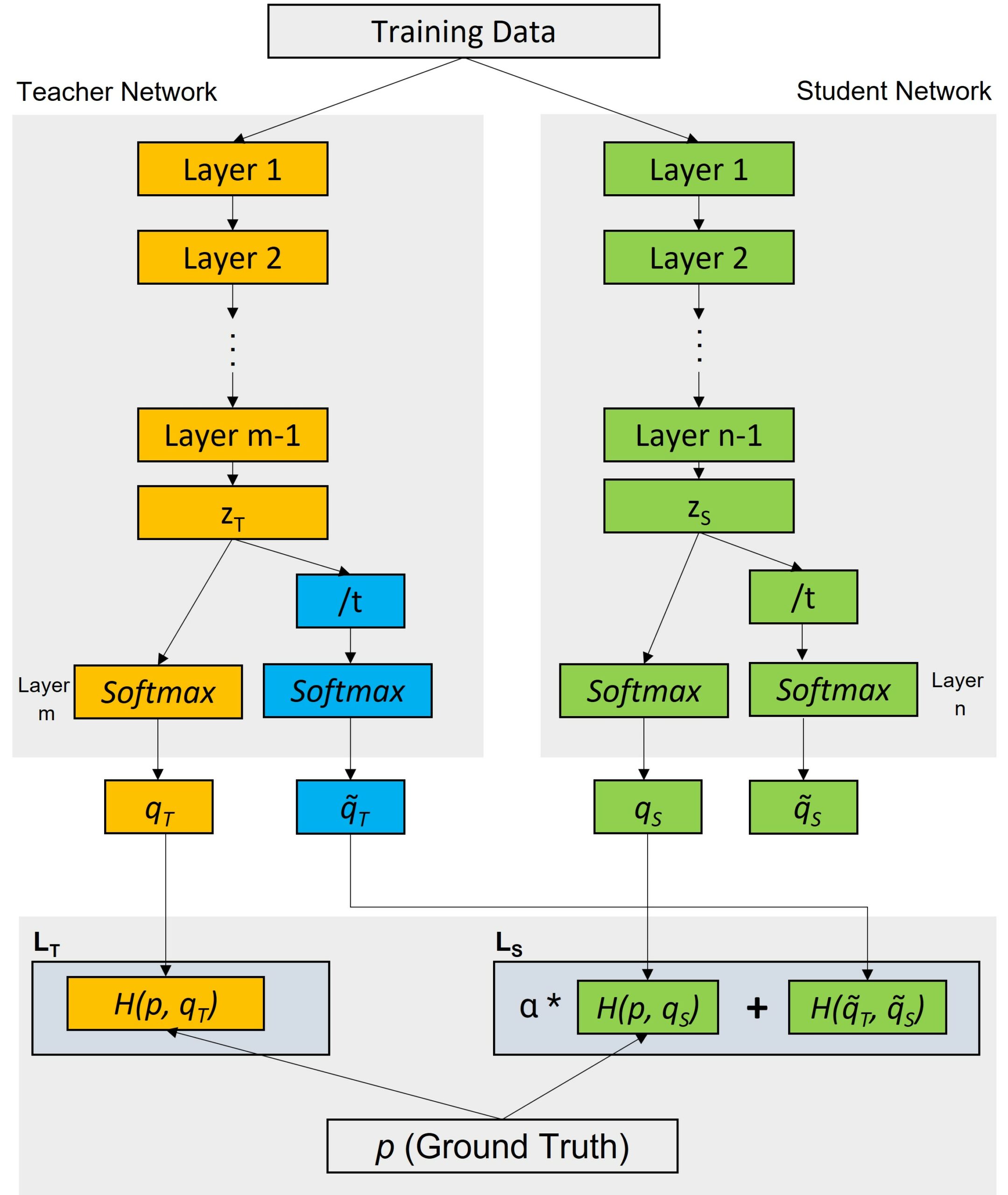

Los procesos de destilación de conocimientos pueden constar de dos etapas principales: un modelo "maestro" produce una versión suavizada de los datos, que luego se utiliza para entrenar el modelo "alumno". La destilación de conocimientos puede ayudar a resolver el problema del sobreajuste, en el que el modelo está excesivamente especializado y funciona mal con nuevos datos. El modelo del "profesor" produce una visión probabilística de los datos para dar al alumno una idea de lo incierto que es con respecto a cada predicción. Durante el entrenamiento del modelo del "alumno", se utilizan objetivos blandos en lugar de las etiquetas reales, lo que mejora el rendimiento de generalización del modelo del alumno.

La destilación de conocimientos se utiliza tanto en el aprendizaje supervisado como en el no supervisado. En el aprendizaje supervisado, la destilación de conocimientos ayuda a reducir los costes computacionales del entrenamiento de modelos mediante la transferencia de conocimientos entre diferentes arquitecturas. Por ejemplo, la destilación de conocimientos puede utilizarse para comprimir modelos con anotaciones costosas manteniendo la precisión. En el aprendizaje no supervisado, la destilación de conocimientos sugiere compartir parámetros entre múltiples fuentes con relaciones variables para ayudar a mejorar la capacidad del modelo de generar múltiples representaciones de los datos.

La destilación de conocimientos puede llevarse a cabo mediante diversas técnicas. Un enfoque habitual es el basado en "pistas", que consiste en proporcionar información limitada sobre el resultado deseado al modelo del alumno. Otra técnica, la del "factor de desvanecimiento", se utiliza para distribuir los conocimientos del profesor al alumno reduciendo lentamente la influencia del primero a lo largo del tiempo.

En general, la destilación de conocimientos es una poderosa herramienta para transferir información compleja de una fuente a sistemas o contextos posteriores. Tiene aplicaciones tanto en el aprendizaje supervisado como en el no supervisado, reduciendo los costes de formación y mejorando la precisión de los modelos.