Дистилляция знаний - это процесс передачи информации и знаний из одного источника в другой. Он может использоваться для создания новых моделей машинного обучения путем дистилляции существующих или для передачи знаний от экспертных систем к начинающим. Это также относится к практике передачи знаний, таких как правила или модели, из первоначального источника в системы, которые менее мощные и имеют меньше ресурсов.

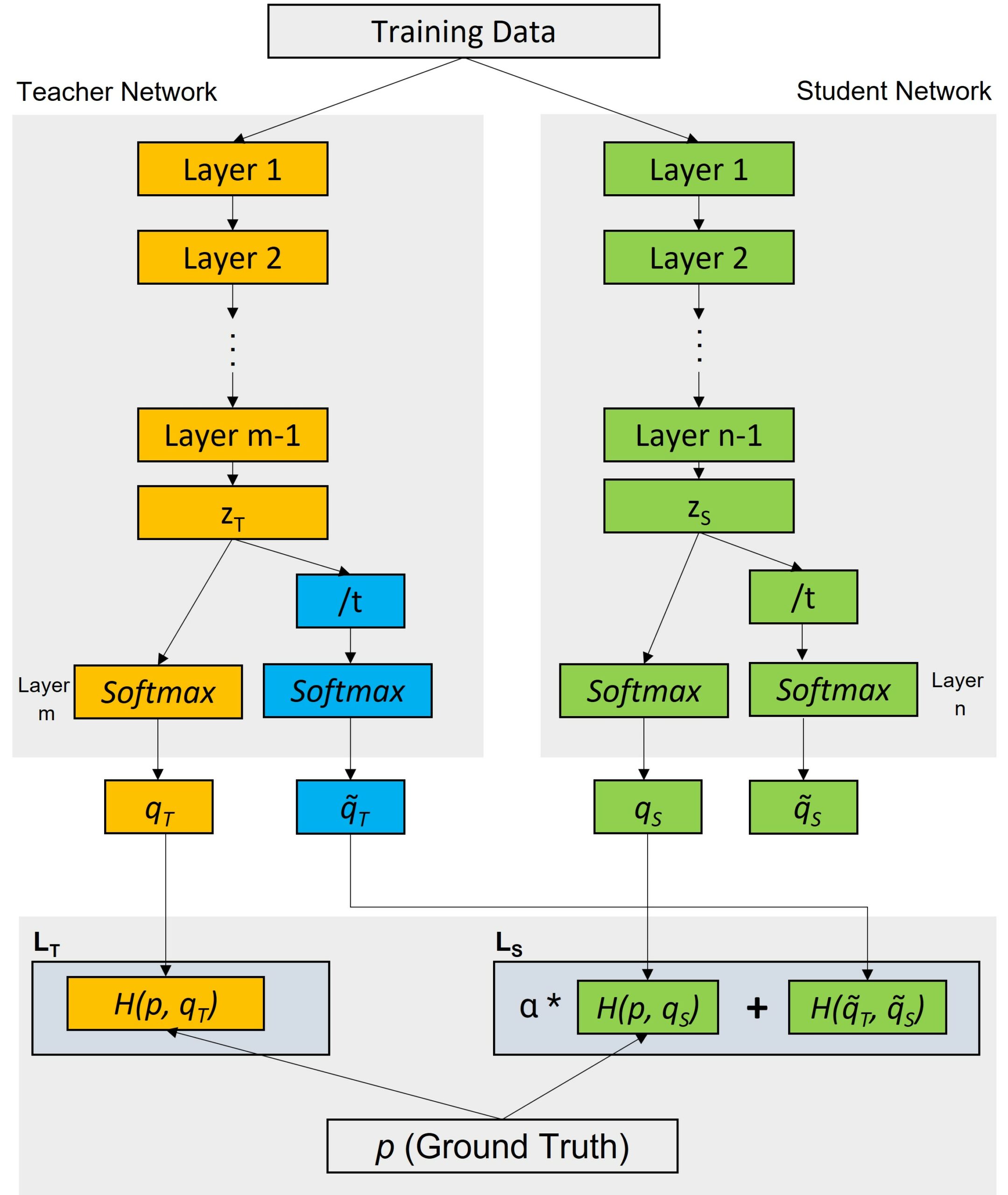

Процесс дистилляции знаний может включать два основных этапа: модель "учителя" создает смягченную версию данных, которая затем используется для обучения модели "ученика". Дистилляция знаний может помочь решить проблему чрезмерной подгонки, когда модель слишком специализирована и плохо работает с новыми данными. Модель "учителя" создает вероятностный взгляд на данные, чтобы дать ученику представление о том, насколько неопределенно он относится к каждому предсказанию. Во время обучения модели "ученика" вместо реальных меток используются мягкие цели, что повышает эффективность обобщения модели ученика.

Дистилляция знаний используется как в контролируемом, так и в неконтролируемом обучении. В контролируемом обучении дистилляция знаний помогает снизить вычислительные затраты на обучение модели путем переноса знаний между различными архитектурами. Например, дистилляция знаний может быть использована для сжатия моделей с дорогостоящими аннотациями при сохранении точности. В неконтролируемом обучении дистилляция знаний предполагает обмен параметрами между несколькими источниками с различными связями, что помогает повысить способность модели генерировать различные представления данных.

Дистилляция знаний может быть реализована с помощью различных методов. Одним из распространенных подходов является подход, основанный на "подсказках", который предполагает предоставление ограниченной информации о желаемом выходе для модели учащегося. Другая техника, техника "затухающего фактора", используется для распределения знаний от учителя к ученику путем медленного уменьшения влияния первого с течением времени.

В целом, дистилляция знаний - это мощный инструмент для передачи сложной информации из источника в последующие системы или контексты. Он находит применение как в контролируемом, так и в неконтролируемом обучении, снижая затраты на обучение и повышая точность моделей.