La distillation des connaissances est un processus de transfert d'informations et de connaissances d'une source à une autre. Elle peut être utilisée pour créer de nouveaux modèles d'apprentissage automatique en distillant des modèles existants, ou pour transmettre des connaissances de systèmes experts à des systèmes novices. Elle désigne également la pratique consistant à transférer des connaissances, telles que des règles ou des modèles, d'une source originale à des systèmes moins puissants et disposant de moins de ressources.

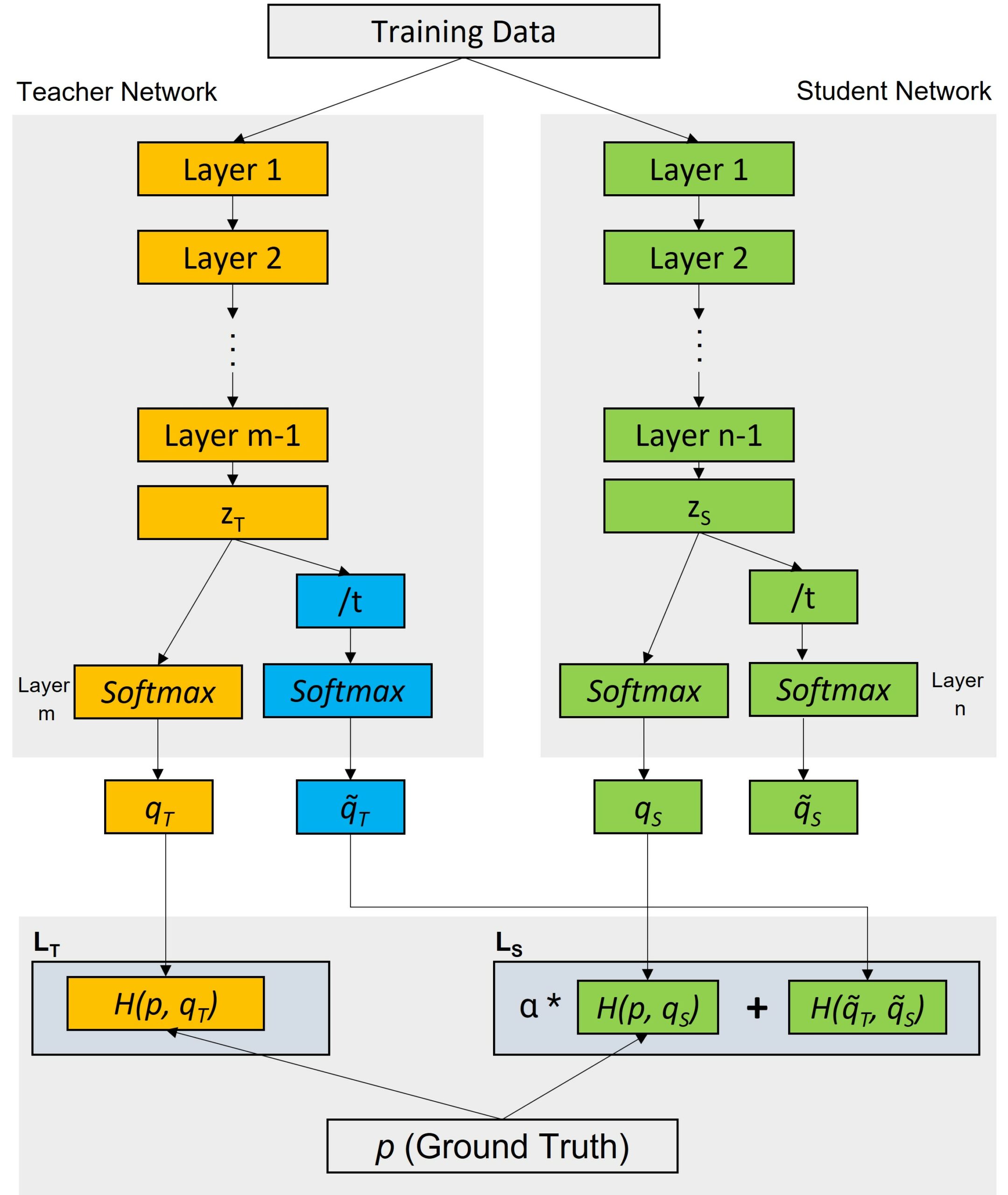

Les processus de distillation des connaissances peuvent comporter deux étapes principales : un modèle "enseignant" produit une version adoucie des données, qui est ensuite utilisée pour former le modèle "étudiant". La distillation des connaissances peut aider à résoudre le problème de l'ajustement excessif, lorsque le modèle est trop spécialisé et donne de mauvais résultats avec de nouvelles données. Le modèle "enseignant" produit une vue probabiliste des données pour donner à l'élève une idée du degré d'incertitude de chaque prédiction. Lors de l'apprentissage du modèle "élève", des cibles douces sont utilisées à la place des étiquettes réelles, ce qui améliore les performances de généralisation du modèle élève.

La distillation des connaissances est utilisée à la fois dans l'apprentissage supervisé et non supervisé. Dans l'apprentissage supervisé, la distillation des connaissances permet de réduire les coûts de calcul de l'apprentissage des modèles en transférant les connaissances entre différentes architectures. Par exemple, la distillation de connaissances peut être utilisée pour comprimer des modèles contenant des annotations coûteuses tout en maintenant la précision. Dans l'apprentissage non supervisé, la distillation des connaissances suggère le partage des paramètres entre plusieurs sources ayant des relations variables afin d'améliorer la capacité du modèle à générer des représentations multiples des données.

La distillation des connaissances peut être mise en œuvre à l'aide de diverses techniques. L'une des plus courantes est l'approche "basée sur des indices", qui consiste à fournir au modèle de l'étudiant des informations limitées sur la sortie souhaitée. Une autre technique, celle du "facteur d'évanouissement", est utilisée pour distribuer les connaissances de l'enseignant à l'étudiant en réduisant lentement l'influence de l'enseignant au fil du temps.

Dans l'ensemble, la distillation des connaissances est un outil puissant pour transférer des informations complexes d'une source vers des systèmes ou des contextes en aval. Elle trouve des applications dans l'apprentissage supervisé et non supervisé, réduisant les coûts de formation et améliorant la précision des modèles.