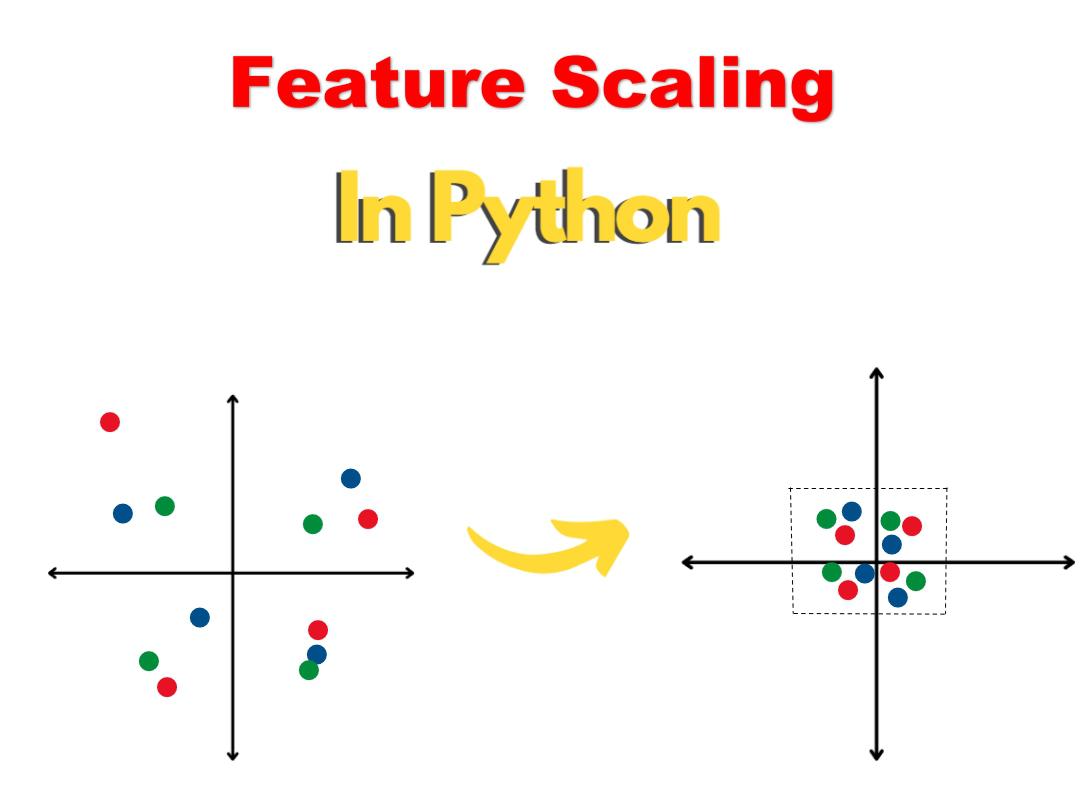

特征缩放是机器学习中使用的一种预处理技术,用于规范输入特征中的数值范围。这是一种数据归一化,用于确保所有的输入变量都在一个类似的尺度上,数值范围在0和1之间。这是一个重要的步骤,因为当所有的参数保持在相同的尺度上时,机器学习算法往往能更好地学习。

特征缩放有时也被称为 "数据归一化 "或只是 "缩放"。它的工作原理是将输入值从原来的范围(即0-255)转换到一个新的范围(即0-1)。这个过程适用于高度、宽度、长度等特征,这样所有的特征都具有同等重要性,模型可以更好地解释它们。

最常见的缩放方法是最小-最大缩放或标准化(z-core)。最小-最大缩放法将所有数值转化为在一个给定范围内,通常是0-1。最小-最大的转换公式为::

X_scaled = (X - Xmin)/(Xmax - Xmin)

另一方面,标准化是重新调整数据的尺度,使平均值变为零,标准差为一。标准化的转换公式是:

X_scaled = (X - μ)/σ

在数据预处理阶段,即机器学习模型的训练之前,通常会应用缩放。这是因为一些模型可能对特征缩放敏感,或者对特征的输入要求在一定范围内。缩放也可以帮助提高某些算法的性能,使它们能够更有效地学习。

当特征缩放没有应用于输入时,某些机器学习算法可能无法正确工作。例如,在k-Nearest Neighbors中,对于数据集中的每个样本,都会计算出一个距离,整个数据集必须保持在一个类似的尺度上,因为它是基于距离的。这意味着,尺度的不同将导致不同的样本被不同的处理,从而导致不希望看到的结果。

总之,特征缩放是机器学习中使用的一种重要的预处理技术,以确保所有参数保持在一个类似的尺度上。它的作用是将输入特征的取值范围转化为新的取值范围,这可以提高一些算法的性能,并阻止其他算法正常运行。