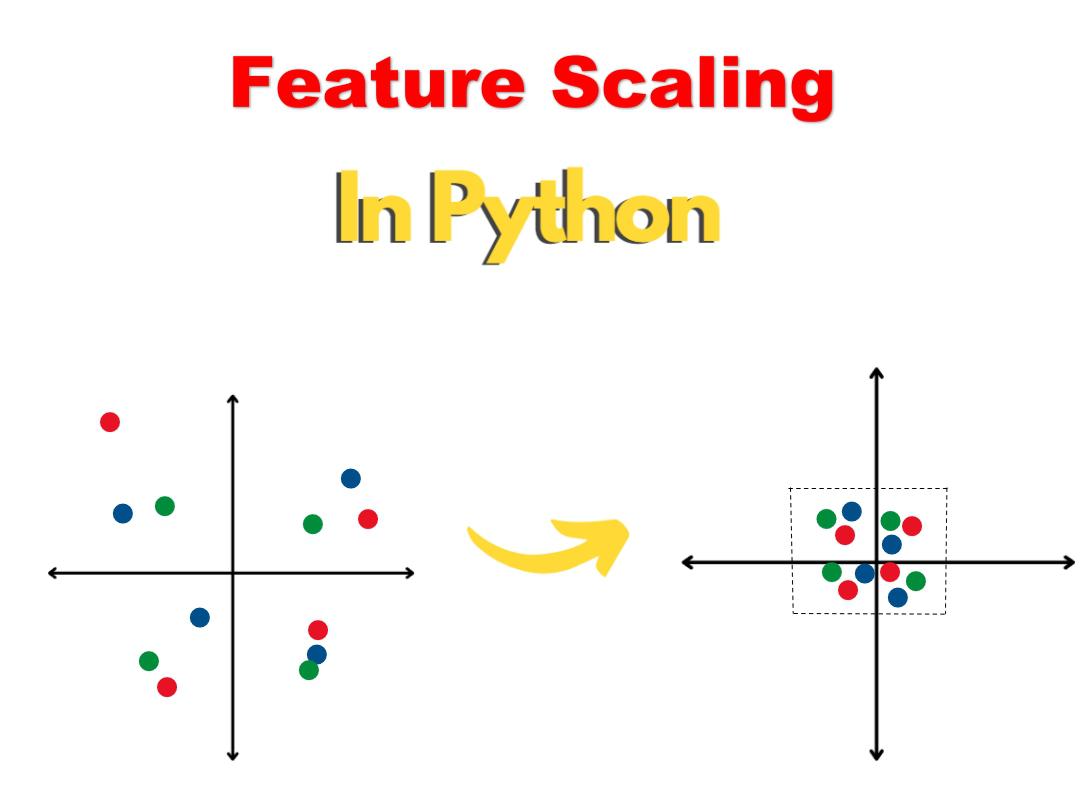

Chia tỷ lệ tính năng là một kỹ thuật tiền xử lý được sử dụng trong học máy để chuẩn hóa phạm vi giá trị trong tính năng đầu vào. Đây là một loại chuẩn hóa dữ liệu được sử dụng để đảm bảo rằng tất cả các biến đầu vào đều có cùng tỷ lệ với các giá trị nằm trong khoảng từ 0 đến 1. Đây là một bước quan trọng vì thuật toán học máy có xu hướng học tốt hơn khi tất cả các tham số vẫn ở cùng một tỷ lệ.

Chia tỷ lệ tính năng đôi khi còn được gọi là “chuẩn hóa dữ liệu” hoặc chỉ “chia tỷ lệ”. Nó hoạt động bằng cách chuyển đổi các giá trị đầu vào từ phạm vi ban đầu (tức là 0-255) sang phạm vi mới (tức là 0-1). Quy trình này được áp dụng cho các đặc điểm như chiều cao, chiều rộng, chiều dài, v.v. để tất cả các đặc điểm đều có tầm quan trọng như nhau và mô hình có thể diễn giải chúng tốt hơn.

Các phương pháp chia tỷ lệ phổ biến nhất là chia tỷ lệ tối thiểu-tối đa hoặc tiêu chuẩn hóa (điểm z). Tỷ lệ tối thiểu-tối đa biến đổi tất cả các giá trị nằm trong một phạm vi nhất định, thường là 0-1. Công thức chuyển đổi cho min-max là:

X_scaled = (X – Xmin)/(Xmax – Xmin)

Mặt khác, việc tiêu chuẩn hóa sẽ điều chỉnh lại dữ liệu sao cho giá trị trung bình trở thành 0 và độ lệch chuẩn là 1. Công thức chuyển đổi để chuẩn hóa là:

X_scale = (X – μ)/σ

Chia tỷ lệ thường được áp dụng trong giai đoạn tiền xử lý dữ liệu, trước khi đào tạo mô hình học máy. Điều này là do một số mô hình có thể nhạy cảm với việc chia tỷ lệ tính năng hoặc có yêu cầu đầu vào để các tính năng nằm trong một phạm vi nhất định. Việc mở rộng quy mô cũng có thể giúp cải thiện hiệu suất của một số thuật toán nhất định bằng cách cho phép chúng học hiệu quả hơn.

Khi tính năng chia tỷ lệ không được áp dụng cho đầu vào, một số thuật toán học máy nhất định có thể không hoạt động chính xác. Ví dụ: trong k-Nearest Neighbors, đối với mỗi mẫu trong tập dữ liệu, một khoảng cách được tính toán và toàn bộ tập dữ liệu phải duy trì ở tỷ lệ tương tự vì nó dựa trên khoảng cách. Điều này có nghĩa là sự khác biệt về tỷ lệ sẽ khiến các mẫu khác nhau được xử lý khác nhau, dẫn đến kết quả không mong muốn.

Tóm lại, chia tỷ lệ tính năng là một kỹ thuật tiền xử lý quan trọng được sử dụng trong học máy để đảm bảo tất cả các tham số vẫn ở cùng một tỷ lệ. Nó hoạt động bằng cách chuyển đổi phạm vi giá trị của một tính năng đầu vào thành một phạm vi giá trị mới, có thể cải thiện hiệu suất của một số thuật toán và ngăn các thuật toán khác hoạt động bình thường.