Bagging, còn được gọi là Bootstrap Aggregating, là một thuật toán tập hợp máy học được sử dụng để cải thiện độ chính xác và tính ổn định của các thuật toán học máy được gọi là người học yếu. Nó hoạt động bằng cách đào tạo nhiều mô hình trên các tập hợp con được chọn ngẫu nhiên khác nhau của dữ liệu huấn luyện và sau đó kết hợp tất cả các mô hình bằng cách lấy mức trung bình (hoặc trung bình có trọng số) của chúng. Điều này cải thiện cả độ chính xác và tính tổng quát của mô hình kết quả, thường tốt hơn đáng kể so với những người học yếu.

Bagging được Tom Breiman phát triển vào năm 1994 và là một kiểu học tập theo nhóm, có nghĩa là nó kết hợp một số học viên yếu để tạo ra một mô hình mạnh. Chúng tôi sử dụng phương pháp này để giảm phương sai của một mô hình nhất định mà không làm tăng đáng kể độ lệch của mô hình đó, trái ngược với các phương pháp như tăng cường.

Thuật ngữ “đóng bao” xuất phát từ ý tưởng đóng bao mẫu từ tập dữ liệu huấn luyện, vì các mô hình khác nhau được huấn luyện trên các mẫu khác nhau. Phương pháp này hữu ích cho các vấn đề khác nhau trong lĩnh vực học máy và đã được áp dụng cho nhiều thuật toán khác nhau như Nave Bayes, Máy vectơ hỗ trợ, Cây quyết định và Hồi quy.

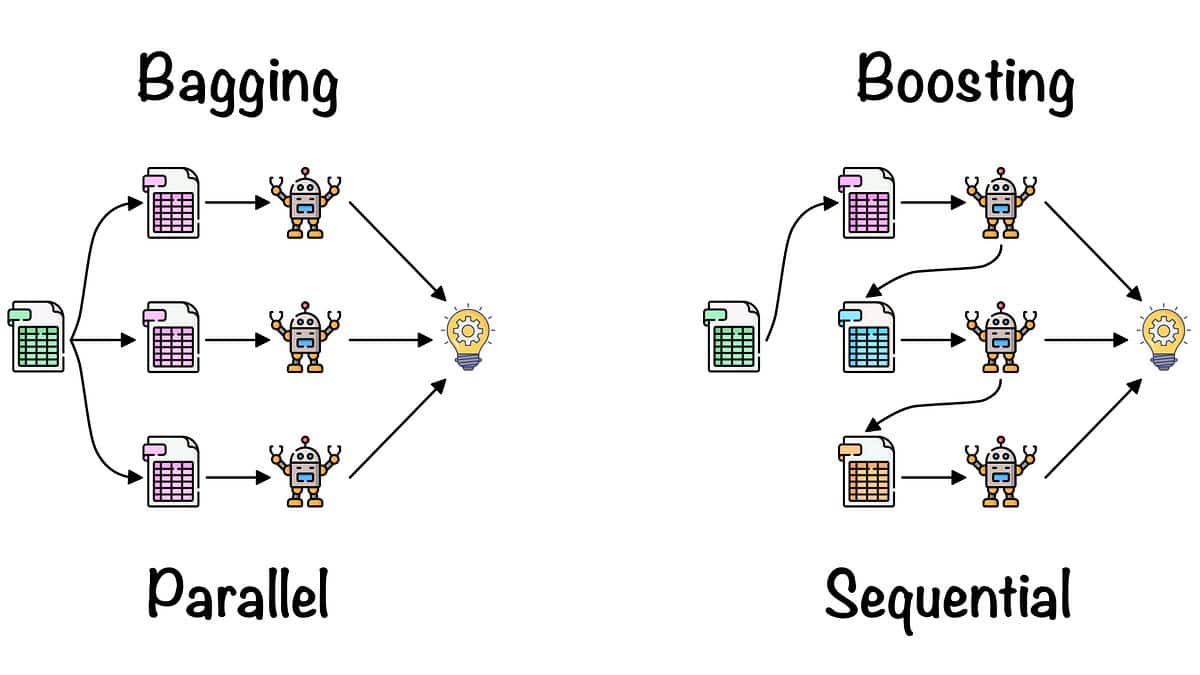

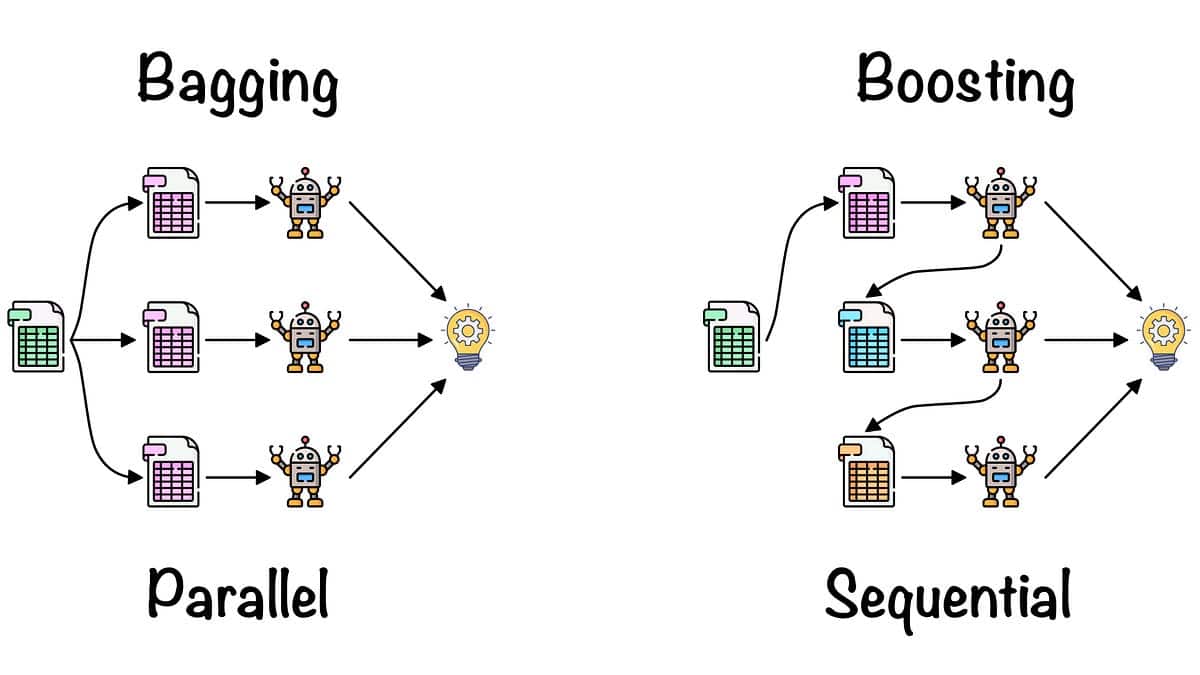

Cách thức hoạt động của việc đóng bao rất đơn giản. Bạn bắt đầu bằng cách lấy một tập hợp con dữ liệu huấn luyện có sẵn. Kích thước tập hợp con thường có thể có cùng kích thước (hoặc nhỏ hơn) so với tập huấn luyện ban đầu. Sau đó, bạn tạo một mô hình dựa trên tập hợp con này. Đây được gọi là “người học yếu”. Quá trình này được lặp lại nhiều lần với các tập hợp con dữ liệu khác nhau. Kết quả cuối cùng là một tập hợp những người học yếu mà sau đó chúng tôi gọi là “mô hình đóng gói”. Mô hình này sau đó được thử nghiệm trên dữ liệu chưa được nhìn thấy và tạo ra độ chính xác và độ ổn định được cải thiện so với một mô hình duy nhất.

Đóng bao là một phương pháp đơn giản nhưng hiệu quả để cải thiện tính chính xác của những người học yếu. Nó nhanh, có khả năng điều chỉnh tốt theo kích thước dữ liệu và khá dễ thực hiện. Đây là một trong những phương pháp tập hợp được sử dụng rộng rãi nhất trong học máy và được sử dụng trong nhiều thuật toán phổ biến như Rừng ngẫu nhiên, AdaBoost và Cây bổ sung.