Le web scraping ou parsing est une méthode utilisée pour extraire des données de sites Web. Lors de l'analyse d'un site Web via un proxy, il est essentiel de trouver un équilibre entre le contenu que vous récupérez et le nombre de requêtes effectuées pour y parvenir. Les implications financières des demandes excessives peuvent rapidement s’accumuler. Nous examinons ici les moyens d'optimiser l'analyse proxy pour plus de rentabilité et d'efficacité.

Parsing proxy et requêtes HTTP : Quel est le lien ?

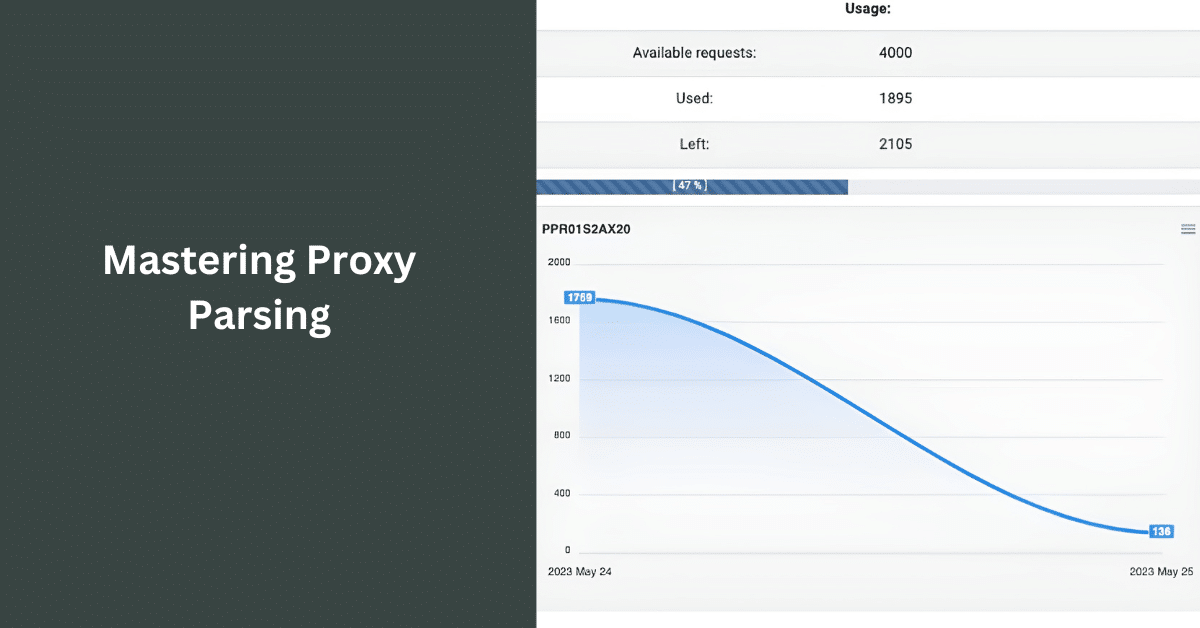

L'analyse proxy consiste à parcourir un site Web à l'aide d'un intermédiaire (proxy), ce qui permet d'anonymiser vos actions, de contourner les restrictions et de gérer la répartition de la charge. Chaque action effectuée lors de l'analyse d'un site Web envoie des requêtes HTTP au serveur du site pour des fichiers ou des ressources. Ces demandes augmentent vos coûts, en particulier lorsqu'elles sont analysées via un proxy facturant par demande. Par conséquent, une stratégie d’analyse optimisée devrait viser à extraire un maximum de données tout en minimisant les requêtes.

Techniques pour minimiser les requêtes HTTP et maximiser l'extraction de contenu

Analyse efficace de la structure du site

Comprendre la structure d'un site web est essentiel pour réduire les demandes inutiles. Investissez du temps dans l'analyse du site web, en identifiant l'endroit où se trouvent les données requises. Cet investissement initial en temps peut permettre d'économiser un nombre considérable de requêtes à long terme en évitant une exploration sans but.

Exploiter les outils de développement des navigateurs

Les navigateurs modernes sont dotés d'outils de développement intégrés, qui offrent une visibilité granulaire sur les ressources chargées par une page et sur les requêtes qu'elle effectue. L'utilisation de ces informations peut s'avérer cruciale pour planifier votre stratégie d'analyse syntaxique.

Consolidation des demandes

Au lieu de faire plusieurs demandes pour différents points de données sur la même page, consolidez-les en une seule demande lorsque c'est possible. Cette approche permet non seulement de réduire le nombre de demandes, mais aussi d'accélérer le processus d'analyse.

Mise en œuvre du chargement paresseux

Le chargement paresseux vous permet de ne charger que le contenu nécessaire, ce qui peut s'avérer particulièrement utile pour les pages contenant des médias lourds tels que des images et des vidéos. En reportant le chargement de certaines ressources jusqu'à ce qu'elles soient nécessaires, vous pouvez réduire considérablement le nombre de requêtes.

Éviter les demandes en double

Assurez-vous que votre algorithme d'analyse évite de faire des demandes répétées pour la même ressource. La mise en œuvre d'un système de suivi pour identifier et ignorer les URL déjà analysées réduira considérablement le nombre de requêtes redondantes.

Utiliser le cache à bon escient

Un système de mise en cache bien implémenté peut être salvateur. Il stocke les résultats des requêtes précédentes, qui peuvent être réutilisés pour des requêtes identiques ultérieures, ce qui réduit considérablement le nombre de requêtes adressées au serveur.

Lien externe :

- "Web Scraping with Proxies : Guide du débutant"

- "Mesures de l'efficacité du site web

- "Minimiser le ralentissement du navigateur"

En utilisant ces stratégies et en comprenant les subtilités des requêtes HTTP, vous pouvez réussir à trouver l'équilibre délicat entre l'extraction d'un maximum de contenu et le maintien d'un minimum de requêtes.