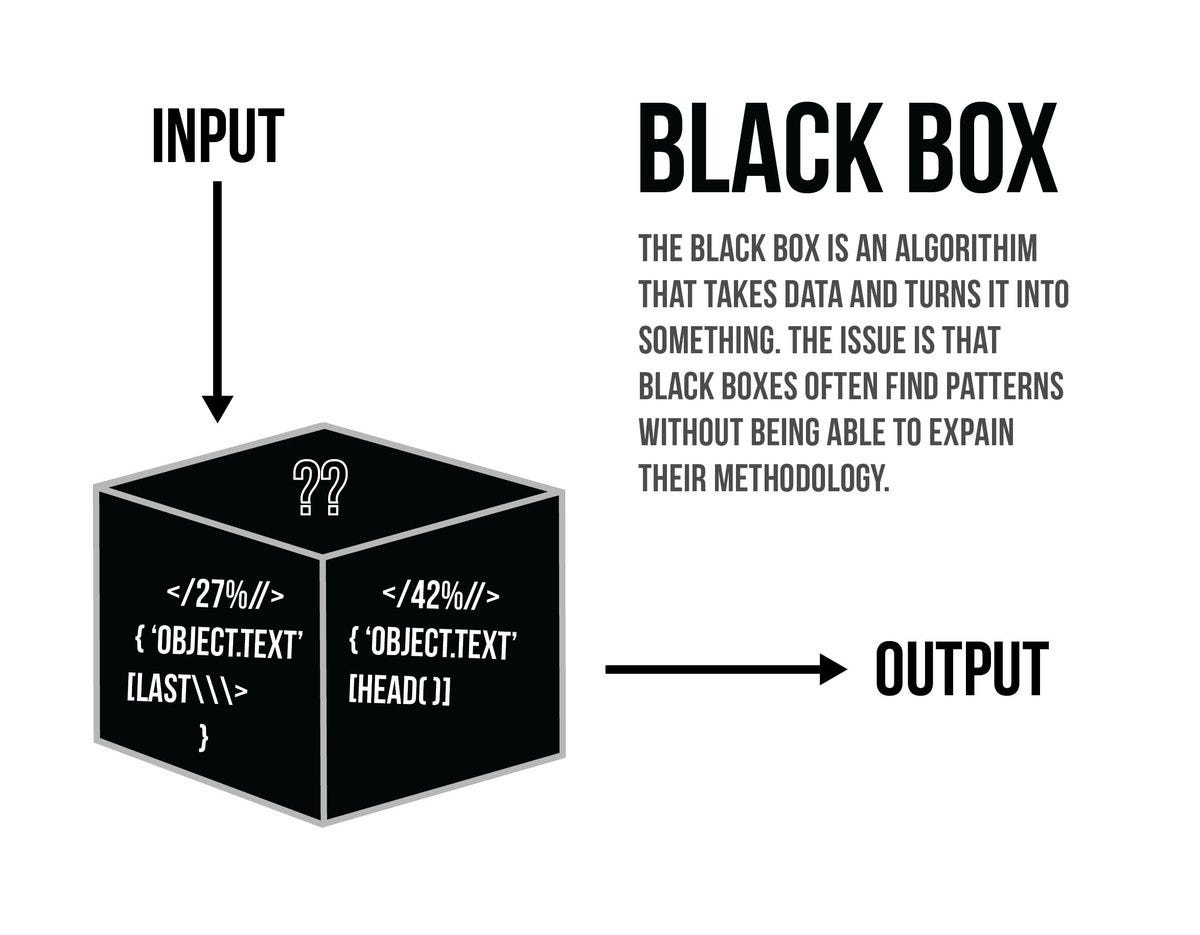

L'interprétabilité dans l'apprentissage automatique est le concept qui consiste à rendre les modèles d'apprentissage automatique et les décisions qui y sont associées plus compréhensibles pour les humains. Ce concept gagne en importance car l'apprentissage automatique est de plus en plus utilisé pour prendre des décisions dans des domaines sensibles, tels que les voitures autonomes ou les modèles financiers. L'interprétabilité est importante car elle permet aux humains de comprendre pourquoi les modèles ont fait ce qu'ils ont fait, et ils peuvent alors vérifier les biais ou autres problèmes que le modèle pourrait avoir.

Pour rendre un modèle d'apprentissage automatique plus facile à interpréter, plusieurs approches sont possibles. L'une d'entre elles consiste à utiliser des algorithmes d'apprentissage automatique plus simples et plus performants, tels que les arbres de décision ou les voisins les plus proches. En effet, les modèles plus simples sont plus faciles à comprendre et à interpréter. Il est également important de regrouper les données en catégories significatives ou d'appliquer une forme de réduction de la dimensionnalité pour réduire la complexité des données.

Un autre aspect important de l'interprétabilité dans l'apprentissage automatique est l'utilisation d'ensembles de validation et de test pour s'assurer que le modèle ne souffre pas d'un surajustement. Si un modèle est surajusté, il peut donner de bons résultats sur les données d'apprentissage, mais de piètres résultats sur les ensembles de validation et de test. Il peut alors être difficile d'interpréter le modèle, car il peut ne pas bien se généraliser à d'autres données.

Enfin, il est important d'expliquer le modèle à l'aide de visualisations, telles que des arbres de décision ou des cartes thermiques. Les visualisations peuvent aider à interpréter rapidement le modèle et à identifier les relations importantes entre les données. En outre, elles peuvent aider à identifier les divergences ou les problèmes qui peuvent être présents dans le modèle.

En résumé, l'interprétabilité de l'apprentissage automatique est un concept important, car elle permet de rendre les modèles d'apprentissage automatique et les décisions qui en découlent plus compréhensibles et plus fiables pour les humains. Il est important d'utiliser des algorithmes plus simples, de regrouper les données en catégories significatives, d'appliquer la réduction des données et d'utiliser des ensembles de validation et de test pour rendre les modèles plus interprétables. En outre, les visualisations peuvent être utilisées pour expliquer le modèle et aider les humains à interpréter les décisions du modèle.